- Detalles

- Categoría: Signals Notebook

- Visto: 35068

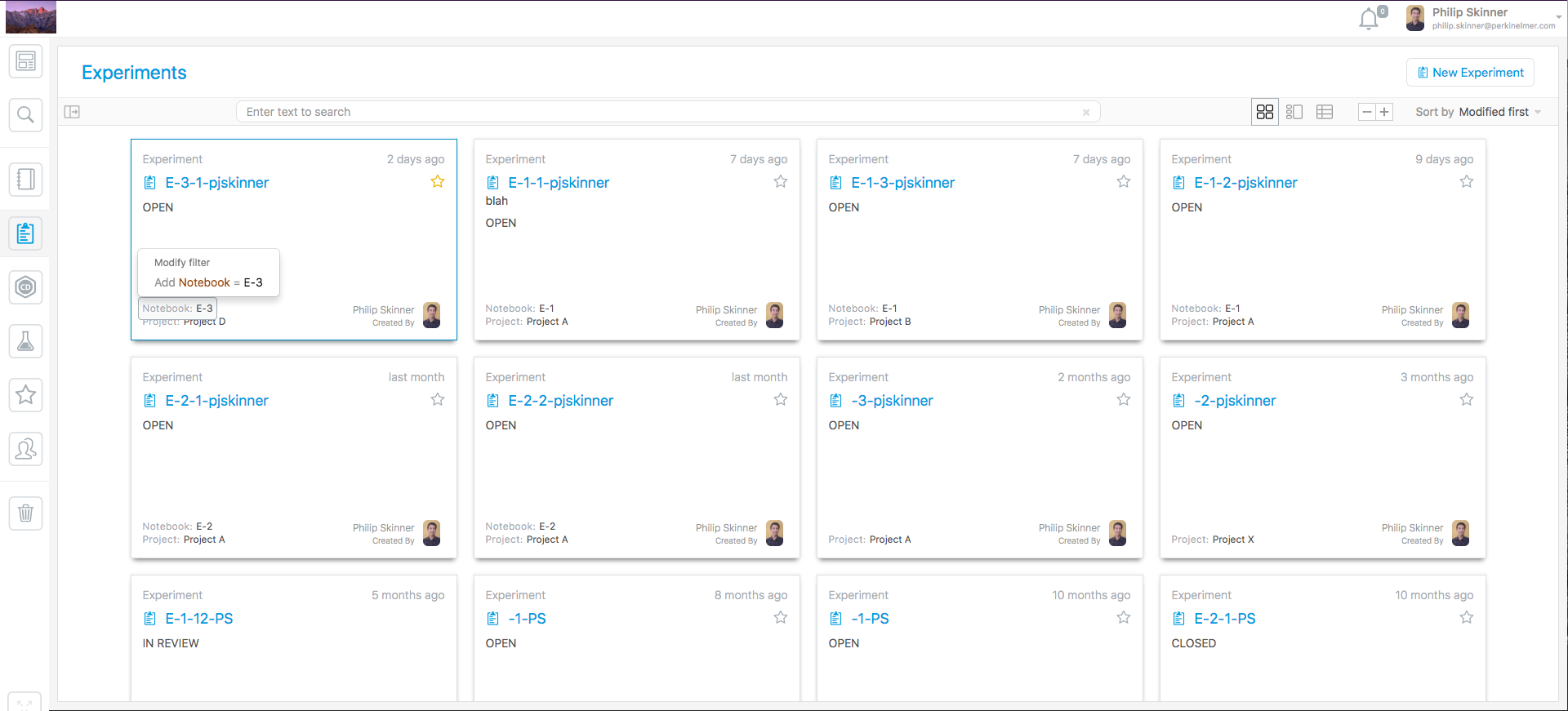

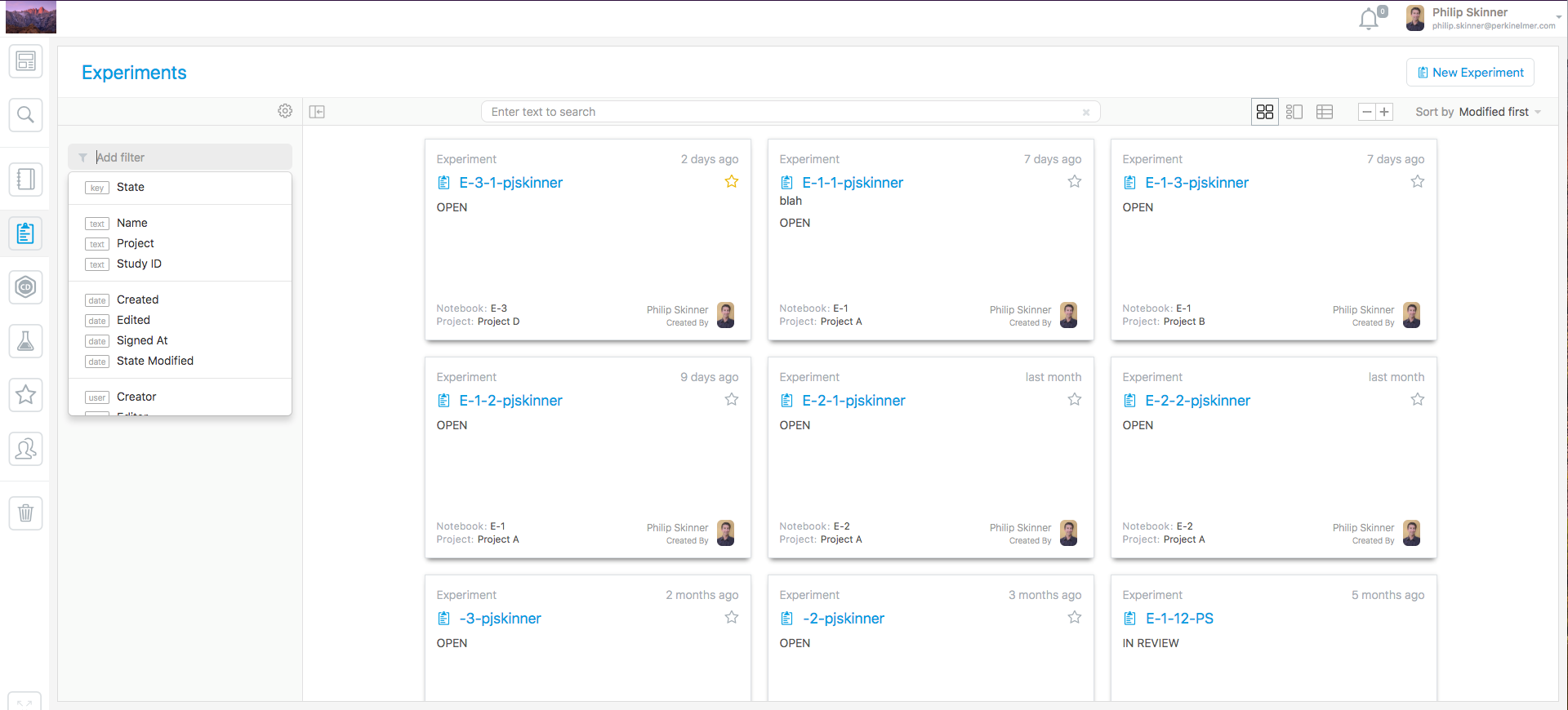

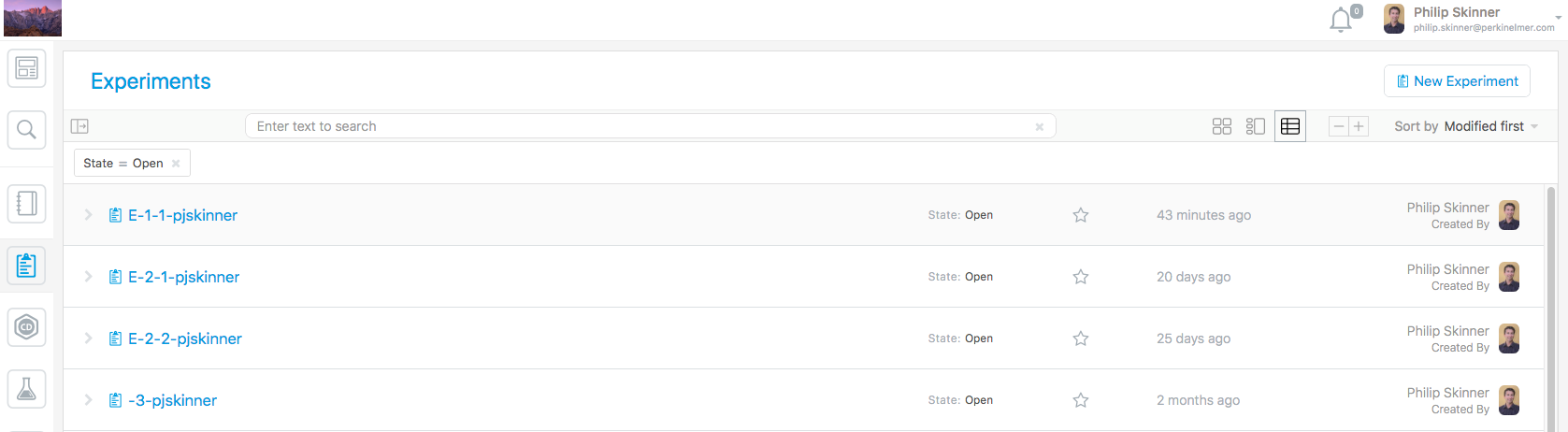

Esta última versión de Signals Notebook pretende, en gran medida, facilitar la búsqueda y filtrado dentro de cuadernos y experimentos.

Búsqueda y actualizaciones de carpetas inteligentes

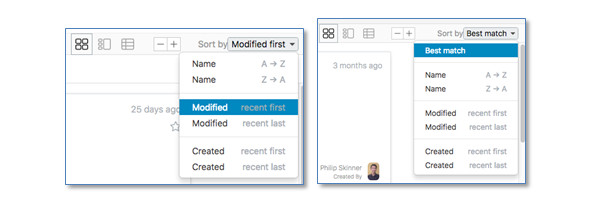

Los cuadernos, experimentos, reacciones y compuestos químicos se han actualizado para ser coherentes con los cambios recientes en la interfaz de búsqueda. Cualquier filtro que aparezca en las carpetas puede ser clicado para ampliar la información.

Los demás filtros se encuentran accesibles en el panel de la izquierda.

Se han incluido clasificaciones adicionales, filtros y opciones de visualización para facilitar y potenciar la herramienta de búsqueda. Las clasificaciones pueden ordenarse por nombre, creación o fecha de modificación, en orden creciente o decreciente.

Los resultados pueden visualizarse en formato lista además de la visualización en tarjetas.

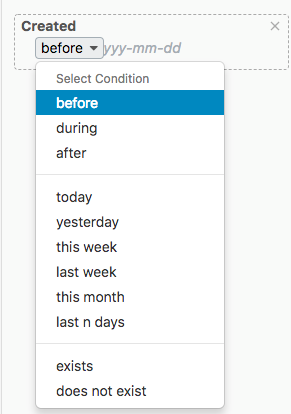

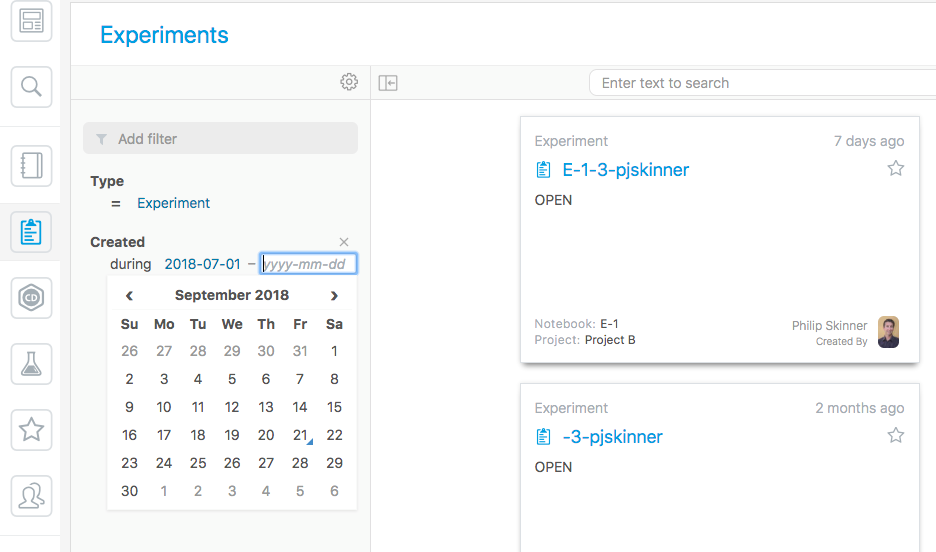

Otra novedad son las búsquedas por fecha. Combinando una de las condiciones “antes”, “durante” y “después” con la selección de una fecha concreta en el calendario, se reducen notablemente los resultados que el cuaderno nos ofrece.

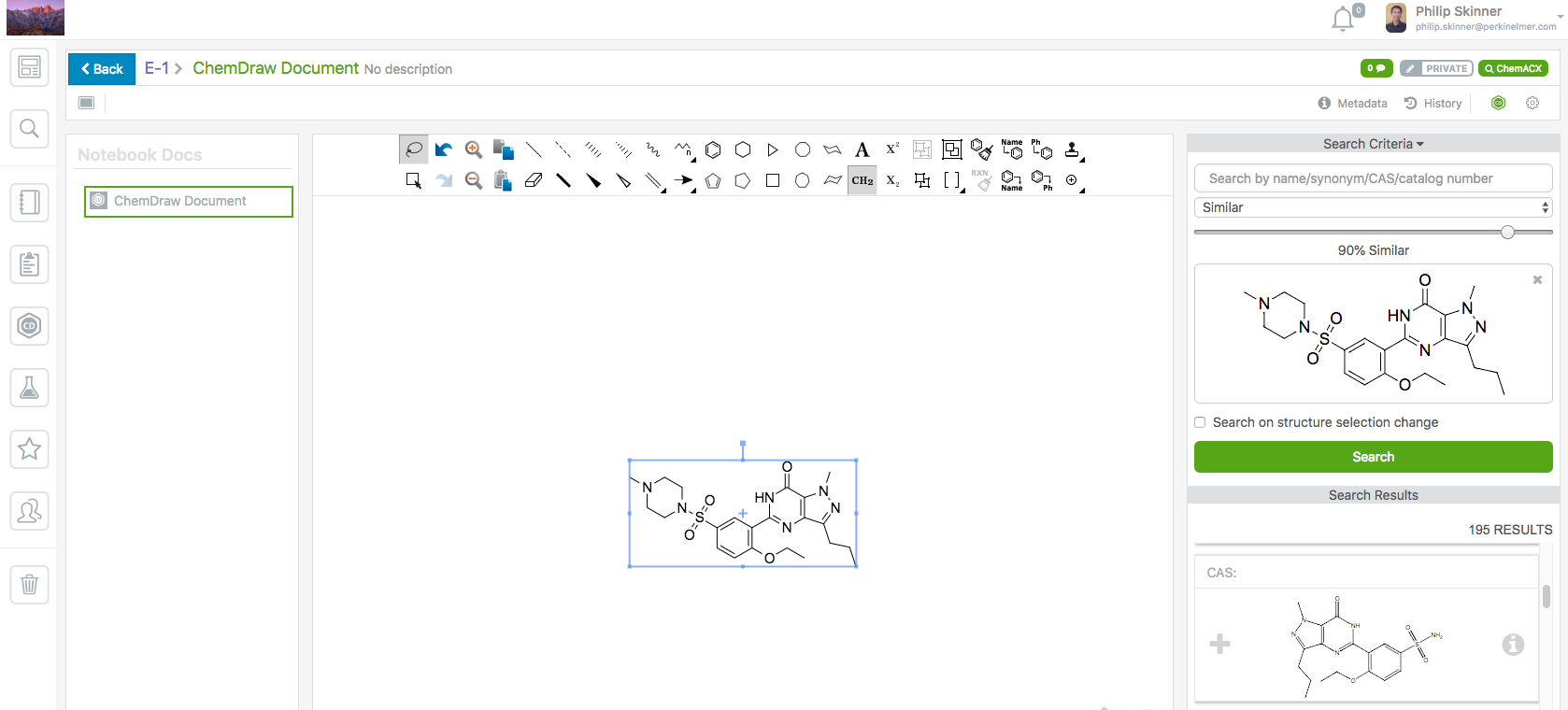

Explorador ChemACX

ChemACX ahora está disponible en los documentos de dibujo químico para documentos agregados desde ChemDraw y para aquellas estructuras que se dibujan directamente en el cuaderno.

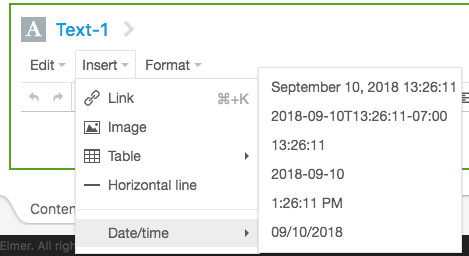

Fecha y hora en elementos de texto

Con el propósito de eliminar la ambigüedad en la asignación de días del mes, se han agregado marcas de fecha/hora adicionales. En particular, figura una marca de fecha/hora consistente con ISO 8601 relativa a UTC.

- Detalles

- Categoría: Comsol

- Visto: 5382

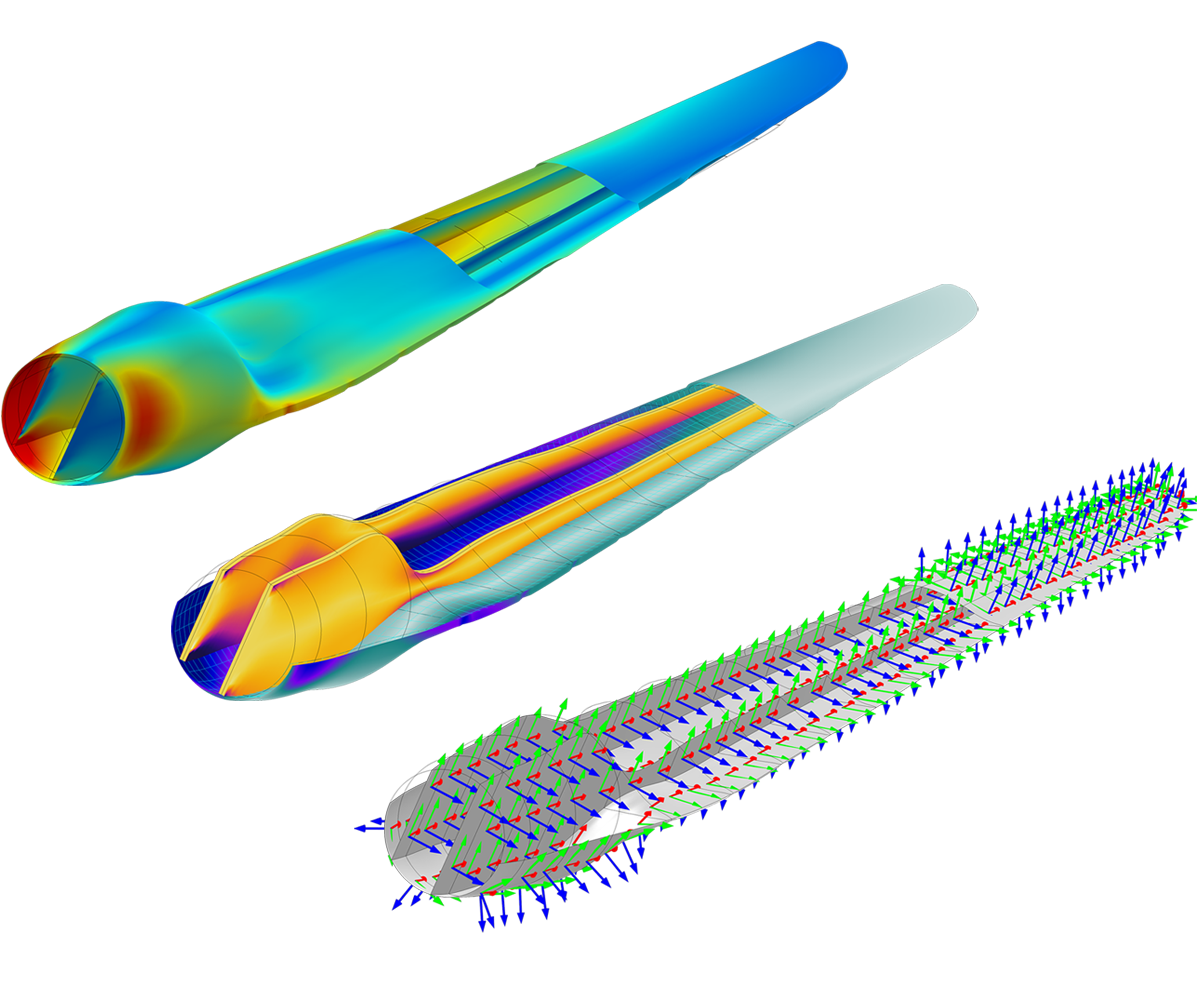

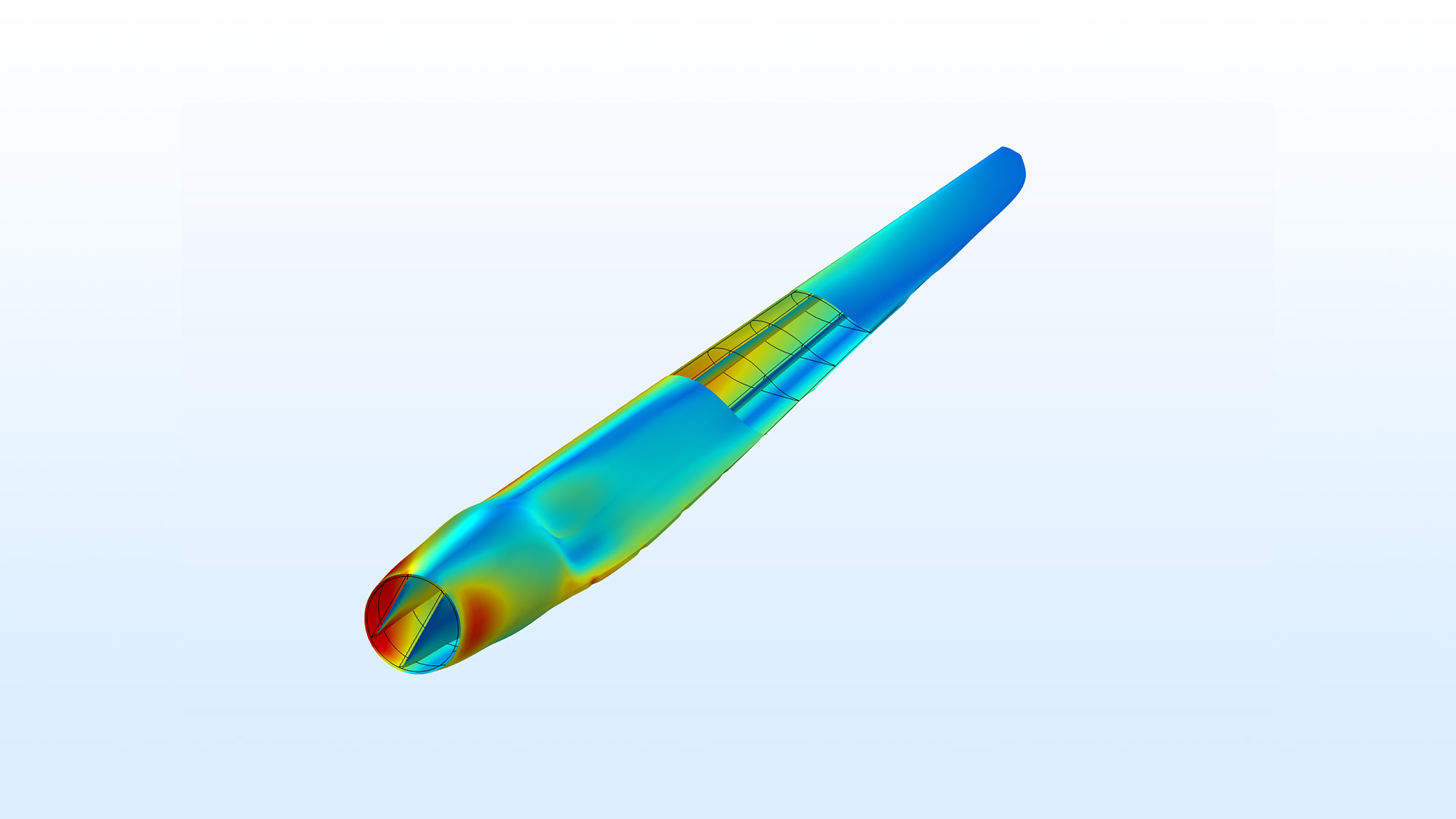

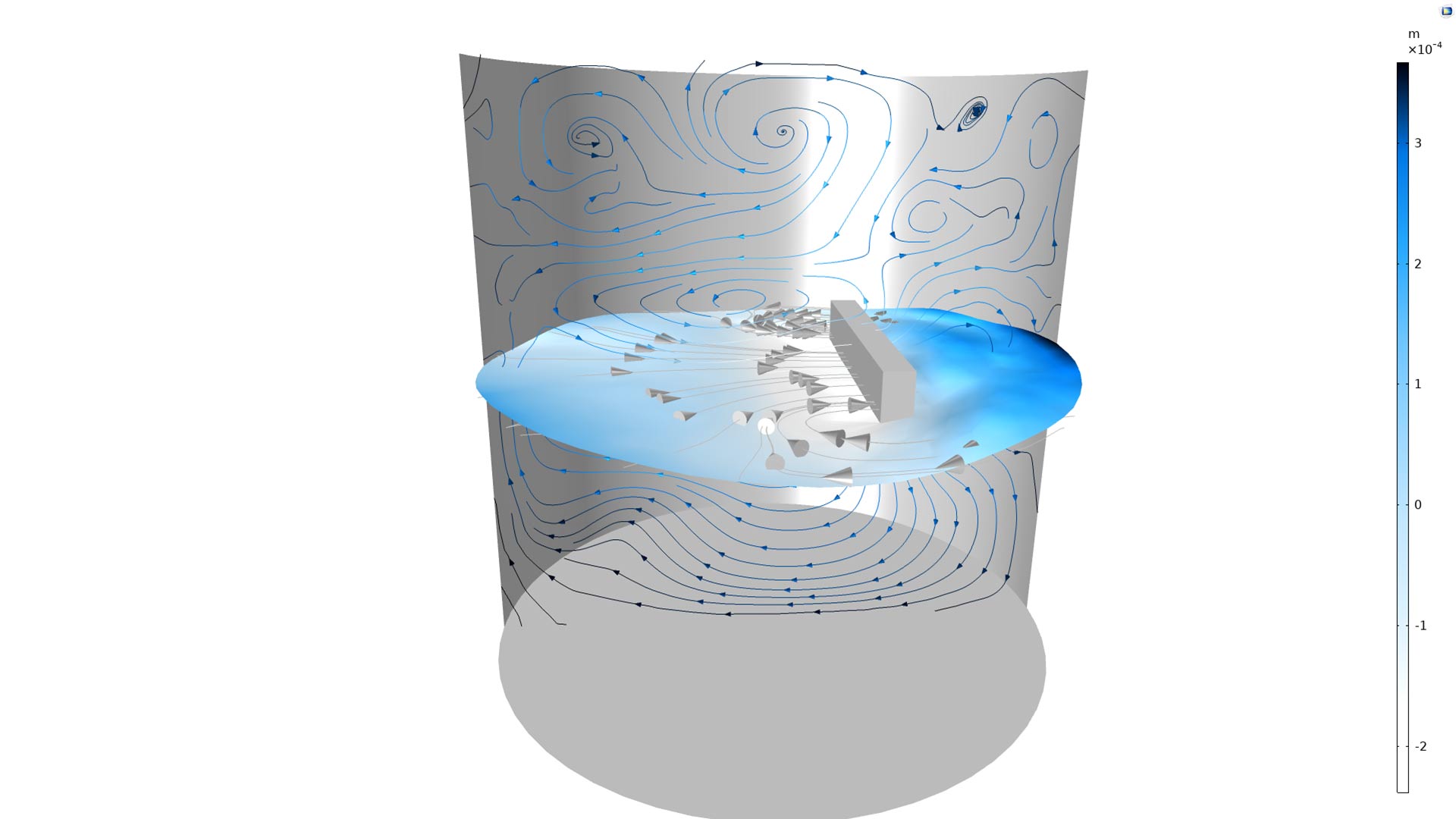

El nuevo módulo de COMSOL Multiphysics, aparecido con la última versión 5.4, Composite Materials Module, permite el modealdo de materiales compuestos multicapa.

Se trata de un módulo que amplía las capacidades de Structural Mechanics Module para modelar materiales compuestos. Los materiales compuestos son materiales heteorgéneos que se forman por la unión de dos o más materiales para conseguir la combinación de propiedades que no es posible obtener con uno solo de los materiales originales. Estos compuestos permiten lograr combinaciones poco usuales de rigidez, resistencia, peso, rendimiento a alta temperatura, resistencia a la corrosión, dureza o conductividad.

El módulo Composite Materials Module proporciona herramientas y funcionalidades de modelado adaptadas para analizar estructuras compuestas por capas. Entre los ejemplos típicos de materiales compuestos en capas se encuentran el plástico reforzado con fibra, las placas laminadas y los paneles tipo sándwich. Estos materiales compuestos en capas son muy utilizados en la fabricación de componentes para aviones, componentes de vehículos espaciales, álabes de aerogeneradores, componentes de automóviles, edificios, cascos de barcos, bicicletas y equipos de seguridad. Composite Materials Module utiliza una tecnología especializada de Material en Capas y proporciona dos enfoques que se pueden utilizar para modelar con precisión las cáscaras compuestas: la teoría de capas y la teoría de una sola capa equivalente.

Como en el caso de todos los módulos de COMSOL, el nuevo módulo de materiales compuestos puede combinarse con cualquiera de los módulos de la familia de productos COMSOL®, para incluir en los modelos fenómenos tan variados como la transferencia de calor, el electromagnetismo o efectos de flujo de fluidos. En este caso todo el modelado se realiza con el mismo flujo de trabajo y dentro del mismo entorno de simulación.

- Detalles

- Categoría: Lakes

- Visto: 8480

Este octubre disponemos de una nueva versión del software de Lakes Environmental, Calpuff View versión 8.6. Esta versión incluye las siguientes novedades:

- Sensitive Receptor Report: Los receptores discretos pueden ser marcados como "Sensitive" con sus resultados apareciendo en un nuevo informe de resumen (Summay Report)

- Background concentratioin Data File Maker: Una nueva utilidad para generar Hourly Background Data Files (BACK.DAT) para la entrada en CALPOST

- Receptor Selection: Visualización de receptor descreto mejorada y selección en las opciones de CALPOST.

- Detalles

- Categoría: Minitab

- Visto: 12794

Por Bonnnie K. Stone

En las partes 1 y 2 de esta serie de artículos se habló sobre cómo la inferencia estadística utiliza los datos de una muestra de individuos para llegar a conclusiones sobre toda la población. Es una herramienta muy potentes, pero cuando se hagan inferencias estadísticas se deben de verificar las suposiciones. La violación de cualquiera de estas suposiciones puede dar lugar a falsos positivos o falsos negativos, invalidando así sus resultados.

Los suposición más frecuentes sobre los datos son: muestras aleatorias, independencia, normalidad, igual varianza, estabilidad, y que el sistema de medición es preciso y exacto. En los artículos anteriores se habló de las muestras aleatorias y en el último, sobre la independencia estadística. Ahora consideremos los supuestos de los sistemas de estabilidad y medición.

¿Qué es la suposición de estabilidad?

Un proceso estable es aquel en el que las entradas y las condiciones son consistentes a lo largo del tiempo. Cuando un proceso es estable, se dice que está "bajo control". Esto significa que las fuentes de variación son consistentes a lo largo del tiempo, y el proceso no presenta una variación impredecible. Por el contrario, si un proceso es inestable y cambia con el tiempo, las fuentes de variación son inconsistentes e impredecibles. Como resultado de la inestabilidad, no se puede confiar en los resultados de sus pruebas estadísticas.

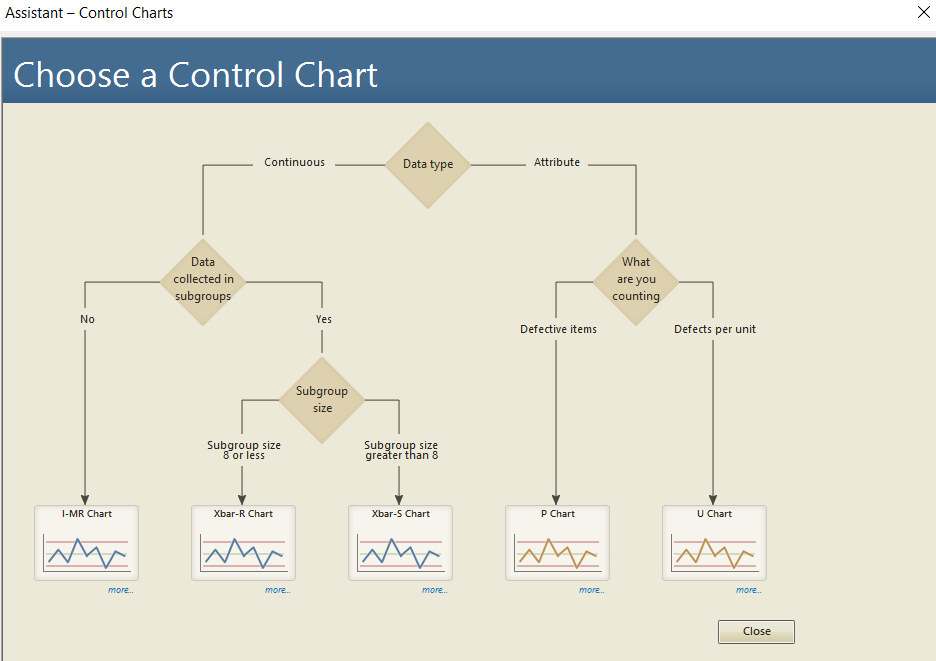

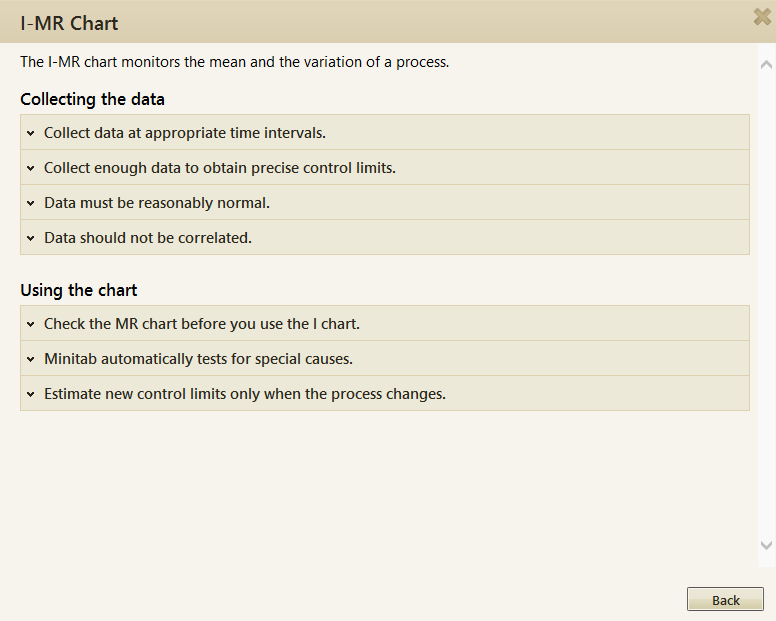

Se puede utilizar alguno de los diversos tipos de gráficos de control disponibles en Minitab Statistical Software para evaluar la estabilidad del conjunto de datos. El menú Asistente puede guiar a través de las opciones para seleccionar el gráfico de control apropiado en función de los datos y el tamaño del subgrupo. Se pueden obtener consejos sobre la recopilación y el uso de datos haciendo clic en el enlace "más".

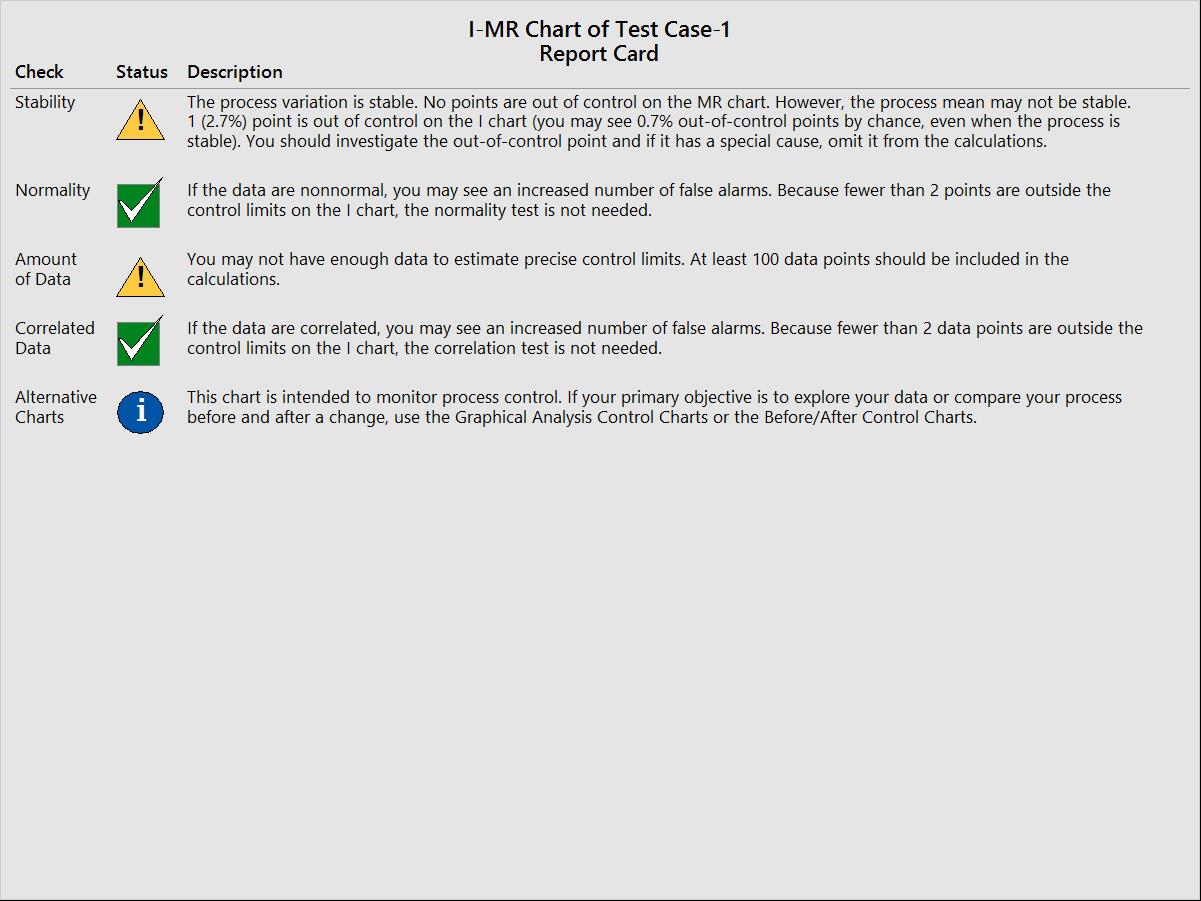

Además de preparar el gráfico de control, Minitab prueba los patrones fuera de control o no aleatorios basados en las Reglas de Nelson y proporciona una evaluación en los informes de fácil lectura de Resumen y Estabilidad. La tarjeta de informe (Report Card), según el gráfico de control seleccionado, verificará automáticamente sus suposiciones de estabilidad, normalidad, cantidad de datos, correlación y sugerirá cuadros alternativos para analizar más a fondo sus datos.

¿Cuál es la suposición para los sistemas de medición?

Todas las otras suposiciones que se han descrito "asumen" que los datos reflejan la realidad. Pero ¿lo hacen?

El sistema de medición es una fuente potencial de variabilidad cuando se mide un producto o proceso. Cuando un sistema de medición es deficiente, pierde la capacidad de "ver" el rendimiento del proceso de manera veraz. Un sistema de medición deficiente conduce a conclusiones incorrectas e implementación defectuosa.

Minitab puede realizar una prueba Gage R&R para los datos de medición y evaluación, dependiendo del sistema de medición. Se puede utilizar el Asistente en Minitab para ayudar a seleccionar la prueba más adecuada según el tipo de sistema de medición que se tenga.

Hay dos suposiciones que deben cumplirse al realizar un Gage R&R para datos de medición:

- El dispositivo de medición debe estar calibrado.

- Las partes a medir deben seleccionarse de un proceso estable y cubrir aproximadamente el 80% del rango de operación posible.

Cuando se utilice un dispositivo de medición, hay que asegurarse de que esté calibrado correctamente y verificar su linealidad, el sesgo y la estabilidad a lo largo del tiempo. El dispositivo debe producir mediciones precisas, en comparación con un valor estándar, en todo el rango de mediciones y durante toda la vida útil del dispositivo. Muchas empresas tienen un departamento de metrología o calibración responsable de calibrar y mantener los medidores.

Ambas suposiciones deben ser satisfechas. Si no lo son, no se puede estar seguro de que lo datos reflejen con precisión la realidad. Y eso significa que existirá un riesgo de no entender las fuentes de variación que influyen en los resultados de su proceso.

La razón real por la que se necesita verificar las suposiciones

La recopilación y el análisis de datos requieren mucho tiempo y esfuerzo. Después de todo el trabajo que se pone en su análisis, es deseable poder llegar a conclusiones correctas. Algunos análisis son robustos para apartarse de estas suposiciones, ¡pero hay que tomar la ruta segura y verificar! Se desea estar seguro de que se puede decir si las diferencias observadas entre las muestras de datos se deben simplemente al azar o si las poblaciones son realmente diferentes.

Es fácil colocar el carro antes que el caballo y simplemente sumergirse en la recopilación y análisis de datos, pero es mucho más inteligente tomarse el tiempo para comprender qué suposiciones de datos se aplican a las pruebas estadísticas que se usarán y planificar en consecuencia.

- Detalles

- Categoría: Comsol

- Visto: 6033

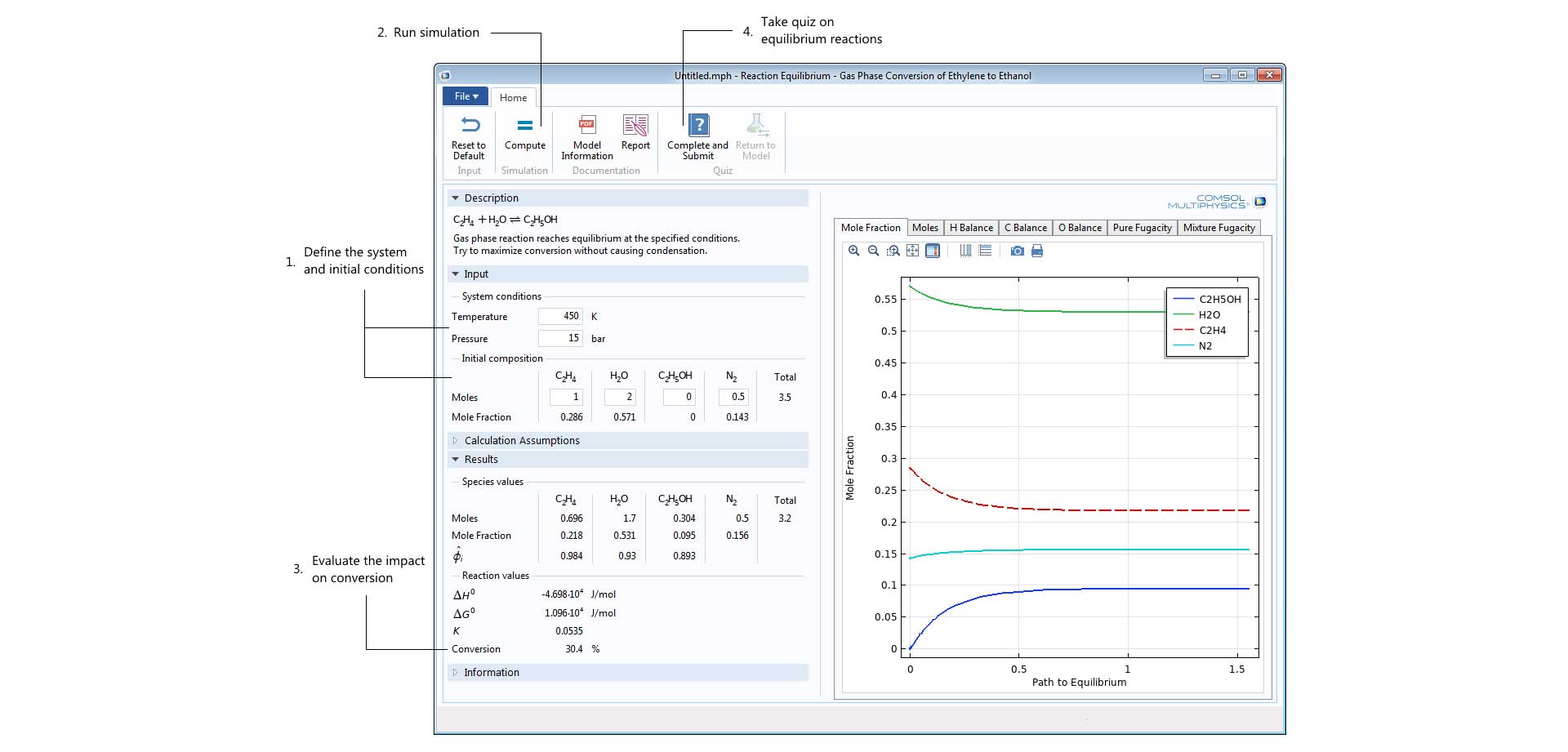

COMSOL Multiphysics® versión 5.4 ya está disponible. La nueva versión incorpora nuevas herramientas de modelado, importantes mejoras del rendimiento, un nuevo módulo para meteriales compuestos (Composite Materials Module) y COMSOL Compiler™ para la creación de apps de modelado y simulación autónomas. Utilizando COMSOL Compiler™, las apps creadas con Application Builder pueden ser compiladas y distribuirse como archivo ejecutable para su uso por cualquiera, sin restricciones de archivos de licencia.

Nuevo producto COMSOL Compiler™

Utilizando el nuevo COMSOL Compiler™, el usuario puede compilar apps desarrolladas utilizando Application Builder en apps ejecutables indpendientemente, que pueden distribuirse y correrse en cualquier plataforma soportada (Windows®, Linux® y macOS) sin la necesidad de un archivo de licencias. Estas apps ejecutables pueden distribuirse dentro de una organización o a un amplio abanico de usuarios. Para compilar y crear apps ejecutables es necesario disponer de una licencia para COMSOL Compiler™.

Nuevo producto: Composite Materials Module

|

El nuevo módulo Composite Materials Module permite modelar laminados compuestos proporcionando un conjunto de herramientas de pre- y postprocesado para estructuras con decenas o centenares de capas. Combinando el módulo Composite Materials Module con nueva funcionalidad para cáscaras estratificadas, disponibles en los módulos Heat Transfer Module y AC/DC Module, los usuarios pueden realizar análisis multifísico en materiales compuestos, como calentamiento Joule en combinación con expansión térmica. |

|

Resumen de las funcionalidades del núcleo

|

Las mejoras en la funcionalidad del núcleo del software COMSOL Multiphysics® incluyen varias prestaciones para organizar mejor el modelo. Se dispone de la capacidad de organizar conjuntos de parámetros en un modelo utilizando múltiples nodos de parámetros, así como la posibilidad de realizar barridos paramétricos sobre múltiples conjuntos de parámetros. Además, se pueden organizar la mayoría de los nodos del Constructor del modelo (Model Builder) en grupos y asignar esquemas de coloreado personalizados a modelos geométricos basados en selecciones. Entre las mejoras de rendimiento existe un nuevo esquema de asignación de memoria que proporciona cálculos varias veces más rápidos en el sistema operativo Windows® para ordenadores con los procesadores más modernos que tengan más de 8 núcleos. |

|

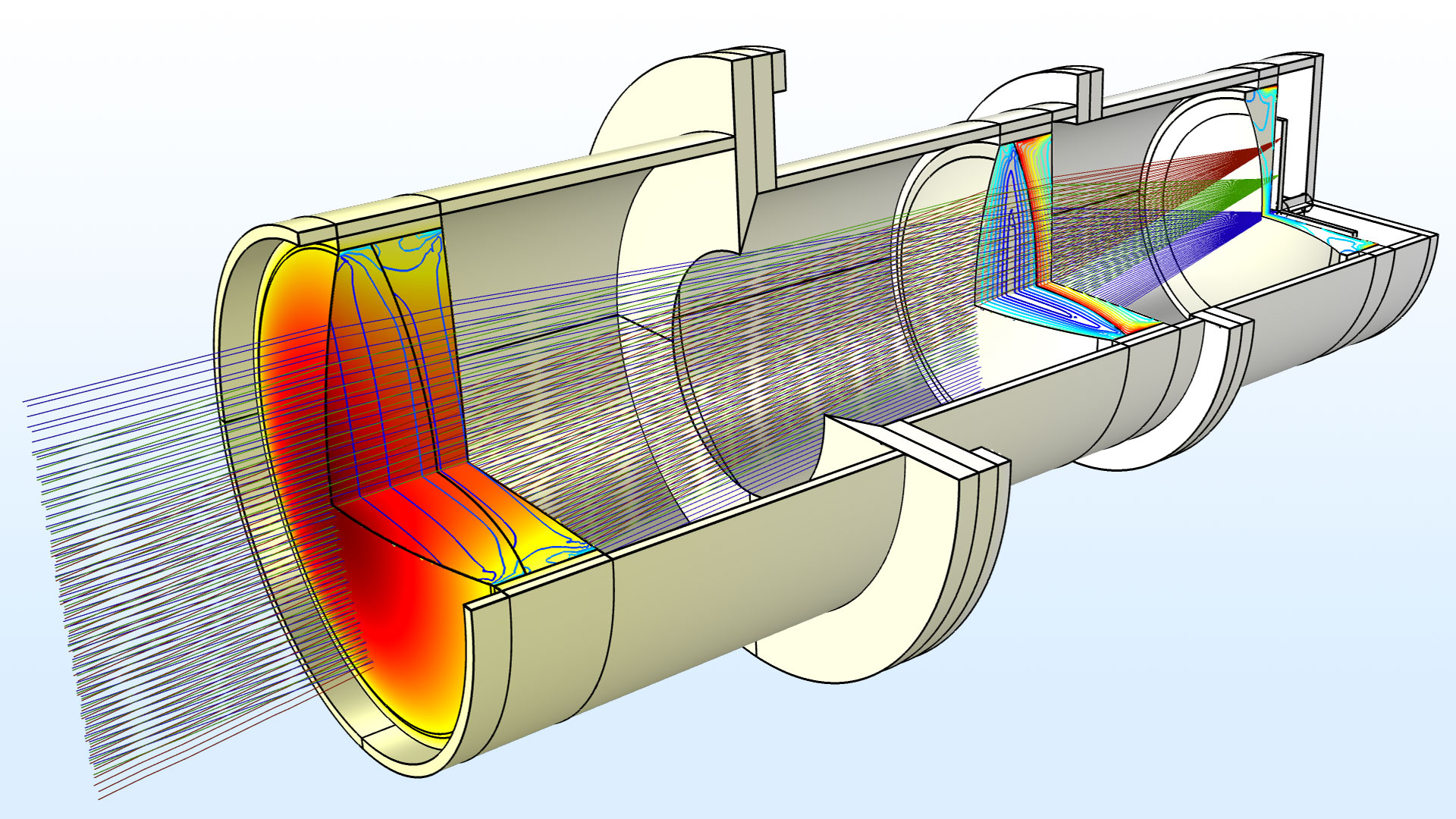

Resumen de Electromagnetismo

|

Para el modelado electromagnético, el módulo AC/DC incorpora una nueva librería de Partes con bobinas y núcleos magnéticos totalmente parmáticos y listos para ser usados. De forma similar, el módulo RF ha mejorado su librería de materiales con nuevos materiales de sustratos para modelado de circuitos impresos de RF, microondas y ondas milimétricas. El módulo Ray Optics Module añade herramientas de modelado mejoradas para análisis STOP (estructural-térmico-óptico). Finalmente, el módulo Semiconductor Module trae una nueva interfaz multifísica Schrödinger-Poisson Equation para conectar con la interfaz Electrostatics. |

|

Resumen de Mecánica estructural y Acústica

|

Si nos vamos al modelado estructual y acústico, el módulo Structural Mechanics Module dispone de nuevas herramientas para análisis espectral de respuesta a los choques, con dos nuevos modelos que demuestran la funcionalidad. Con los módulos Nonlinear Structural Materials Module y Geomechanics Module, ahora se muede modelar el daño en materiales quebradizos como resultado de fisuras. Se ha añadido Interacción Fluido-Estructura (FSI) el módulo Multibody Dynamics Module para estudiar problemas donde un mecanismo interactúa con un fluido. Mientras tanto, en el Acoustics Module, una nueva condición de contorno de puerto facilita el cálculo de transmisión acústica y pérdidas de inserción, y una nueva opción Westervelt no lineal permite el modelado de acústica de presión con altos niveles de presión sonora. |

|

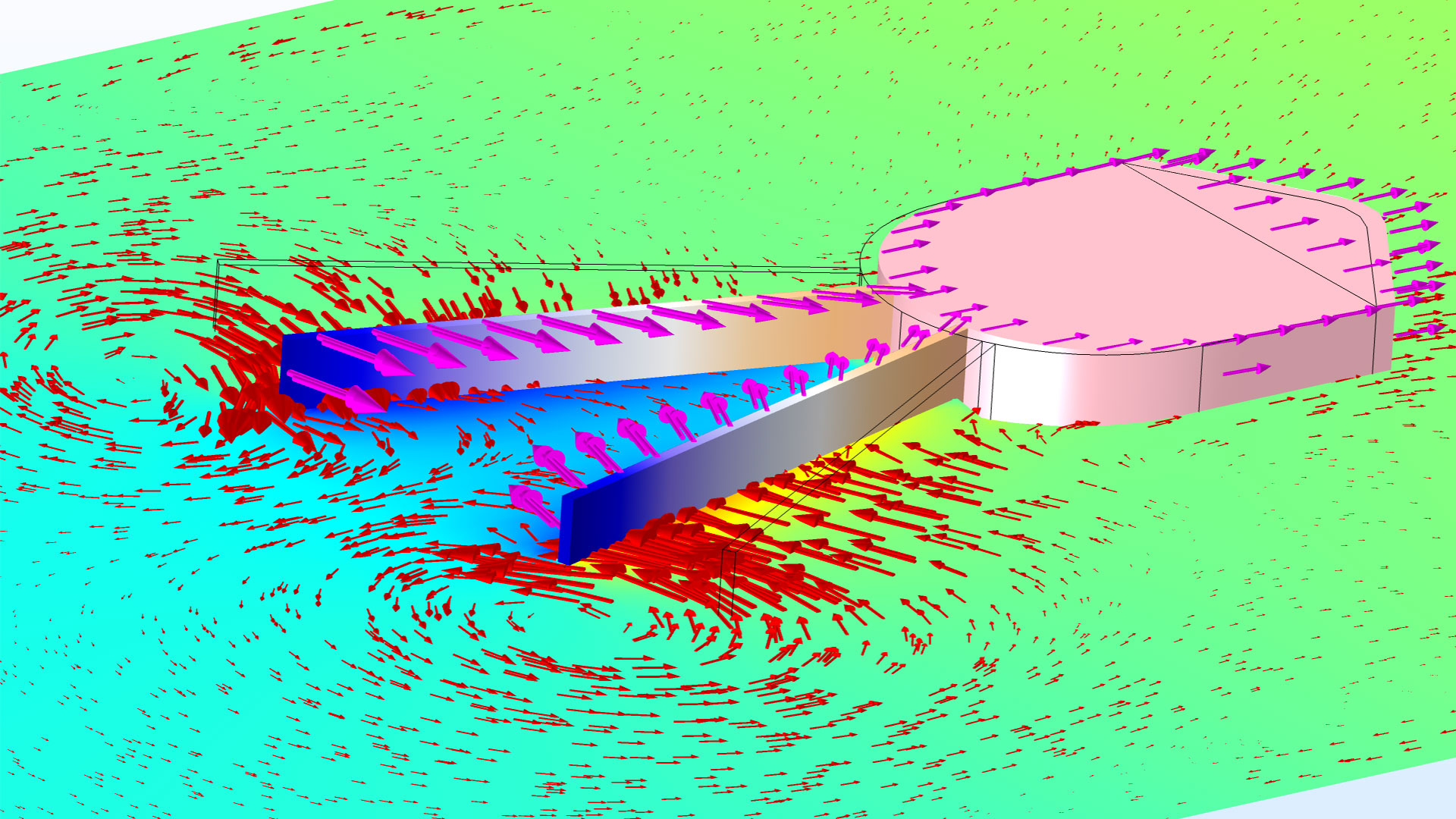

Resumen de Flujo de fluido y Transferencia de calor

|

El módulo CFD trae dos actualizaciones importantes: la capacidad de modelar simulaciones con grandes remolinos (LES) y un conjunto totalmente remozado de herramientas demodelado para flujo multifase, que incluyue una nueva interfaz FSI para flujo multifase. Adicionalmente, se han añadido capacidades multifísicas en el Pipe Flow Module para conectar interfaces de flujo de una fase. Un nuevo método de radiación de calor en el módulo Heat Transfer permite reflexiones difuso-especular y surperficies semitransparentes, y se puede modelar transferencia de calor en estructuras con capas finas. |

|

Resumen de Química y Electroquímica

|

Para usuarios del módulo Chemical Reaction Engineering Module existe una interfaz de Termodinámica reformada y una nueva app que modela la conversión de la fase de gas del etileno y el etanol. Para el modelado electroquímico, el módulo Batteries & Fuel Cells Module proporciona una nueva herramienta para crear modelos concentradosde baterías y los usuarios del Corrosion Module pueden utilizar la interfaz de flujo multifase Level Set. |

|

- Detalles

- Categoría: Minitab

- Visto: 28391

Bonnie K. Stone

En la Parte 1 de esta serie de entradas en el blog de Minitab, Bonnie escribió sobre cómo la inferencia estadística utiliza datos de una muestra de individuos para llegar a conclusiones sobre toda la población. Esa es una herramienta muy potente, pero cuando se hagan inferencias estadísticas se deben de verificar las suposiciones. La violación de cualquiera de estas suposiciones puede dar lugar a falsos positivos o falsos negativos, invalidando así los resultados.

Los suposiciones respecto a los datos más comunes son: muestras aleatorias, independencia, normalidad, igual varianza, estabilidad, y que el sistema de medición es preciso y exacto.

La última vez se habló de las muestras aleatorias y la independencia estadística. Ahora se considerarán los supuestos de Normalidad e Igualdad de Varianza.

¿Qué es la asunción de la normalidad?

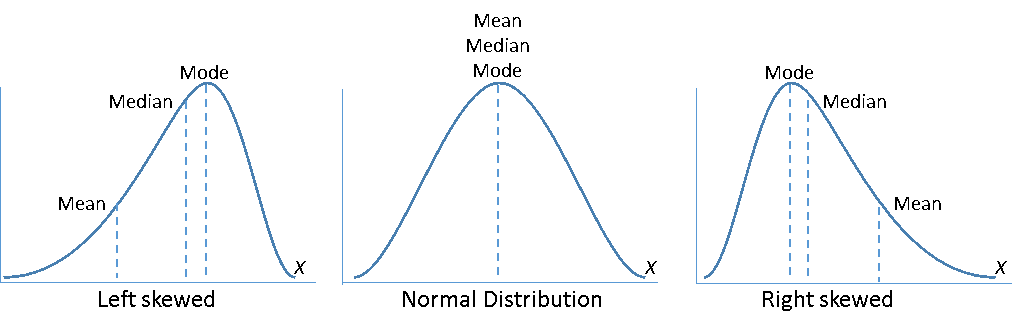

Antes de realizar una prueba estadística, debe averiguarse la distribución de los datos. Si no se hace, hay riesgo de seleccionar una prueba estadística inadecuada. Muchos métodos estadísticos comienzan con el supuesto de que los datos siguen la distribución normal, incluidas las pruebas t de 1 y 2 muestras, la capacidad del proceso, I-MR y ANOVA. Si no se tienen datos distribuidos normalmente, podrá usarse una prueba no paramétrica equivalente basada en la mediana en lugar de la media, o probar la Transformación de Box-Cox o Johnson para transformar los datos no normales en una distribución normal.

Pero se ha de tener en cuenta que muchas herramientas estadísticas basadas en el supuesto de normalidad no requieren datos distribuidos normalmente si los tamaños de muestra son al menos 15 o 20. Pero si los tamaños muestrales son menores de 15 y los datos no están distribuidos normalmente, el p valor puede ser inexacto y deberán interpretarse los resultados con precaución.

Hay varios métodos para determinar la normalidad en Minitab, y en este artículo veremos dos de las herramientas: la Prueba de Normalidad y el Resumen Gráfico.

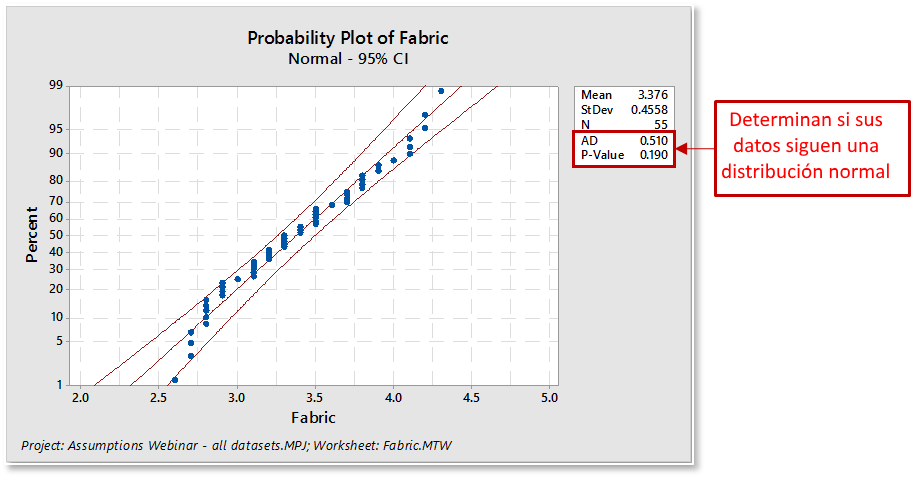

La prueba de normalidad de Minitab generará un gráfico de probabilidad y realizará una prueba de hipótesis de una muestra para determinar si la población de la que se extrae la muestra no es normal. La hipótesis nula establece que la población es normal. La hipótesis alternativa establece que la población no es normal.

Seleccione Estadísticas> Estadísticas básicas> Prueba de normalidad

Al evaluar el ajuste de la distribución para una prueba de normalidad:

- Los puntos trazados formarán aproximadamente una línea recta. Alguna desviación de la línea recta en las colas puede estar bien siempre y cuando se mantenga dentro de los límites de confianza.

- Los puntos trazados deben caer cerca de la línea de distribución ajustada y pasar la prueba del "lápiz grueso". Imagine un "lápiz grueso" que se encuentra en la parte superior de la línea ajustada: si cubre todos los puntos de datos de la gráfica, es probable que los datos sean normales.

- La estadística de Anderson-Darling asociada será pequeña.

- El p valor asociado será mayor que el nivel α elegido (los niveles comúnmente elegidos para α incluyen 0.05 y 0.10).

La estadística de Anderson-Darling es una medida de lo lejos que caen los puntos del gráfico de la línea ajustada en una gráfica de probabilidad. La estadística es una distancia cuadrada ponderada desde los puntos del gráfico hasta la línea ajustada con pesos más grandes en las colas de la distribución. Para un conjunto de datos y una distribución específicos, cuanto mejor se ajuste la distribución a los datos, más pequeña será esta estadística.

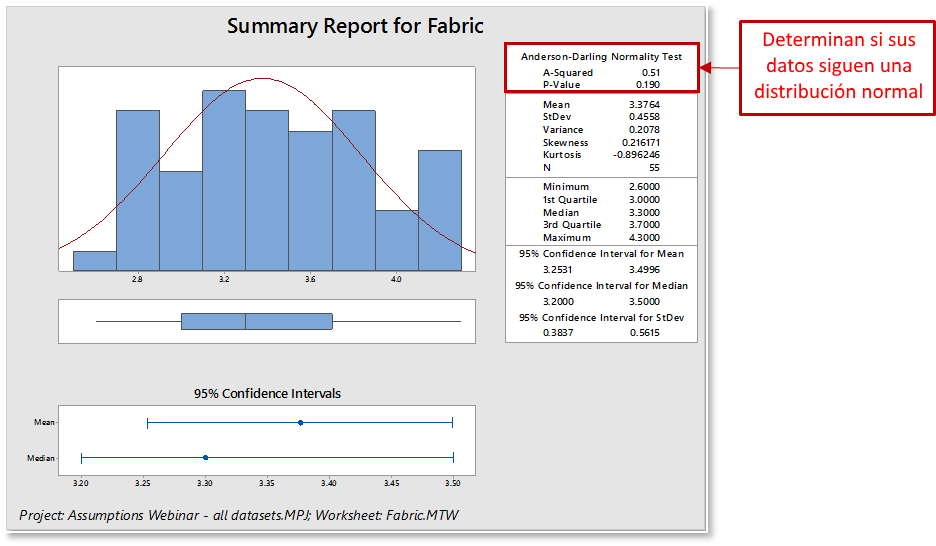

Las estadísticas descriptivas de Minitab con el resumen gráfico generarán una buena visualización de sus datos y calcularán el valor de Anderson-Darling & p-valor. El resumen gráfico muestra cuatro gráficos: histograma de datos con una curva normal superpuesta, diagrama de caja e intervalos de confianza del 95% para la media y la mediana.

Seleccione Estadísticas> Estadísticas básicas> Resumen gráfico

Al interpretar un informe de resumen gráfico para la normalidad:

- Los datos se mostrarán como un histograma. Busque la forma en que se distribuyen sus datos (normal o sesgada), cómo se distribuyen los datos en el gráfico y si hay valores atípicos.

- La estadística asociada de Anderson-Darling será pequeña.

- El valor p asociado será mayor que el nivel α elegido (los niveles comúnmente elegidos para α incluyen 0.05 y 0.10).

Para algunos procesos, como los datos de tiempo y ciclo, los datos nunca se distribuirán normalmente. Los datos no normales están bien para algunos métodos estadísticos, pero asegúrese de que sus datos cumplan con los requisitos para su análisis particular.

¿Qué es la asunción de igual varianza?

En términos simples, la varianza se refiere al ensanchamiento o dispersión de los datos. Las pruebas estadísticas, como el análisis de varianza (ANOVA), suponen que, aunque diferentes muestras pueden provenir de poblaciones con diferentes medias, tienen la misma varianza. Varianzas iguales (homoscedasticidad) es cuando las varianzas son aproximadamente iguales en todas las muestras. Las varianzas desiguales (heterocedasticidad) pueden afectar a la tasa de error de Tipo I y llevar a falsos positivos. Si se están comparando dos o más medias de muestra, como en la prueba t de 2 muestras y ANOVA, una varianza significativamente diferente podría ocultar las diferencias entre las medias y llevar a conclusiones incorrectas.

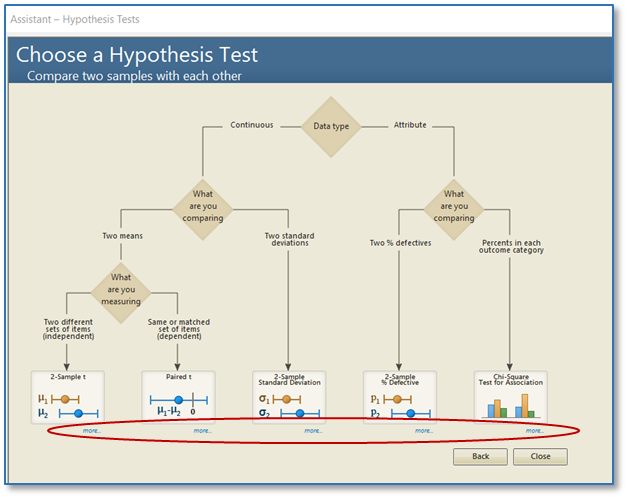

Minitab ofrece varios métodos para probar la igualdad de varianzas. Se puede consultar la Ayuda de Minitab para decidir qué método usar de acuerdo con el tipo de datos que se tienen. También es posible utilizar el Asistente de Minitab para verificar esta suposición. (Consejo: cuando se use el Asistente, haciendo clic en "más" se pueden ver consejos de recopilación de datos e información importante sobre cómo Minitab calcula los resultados).

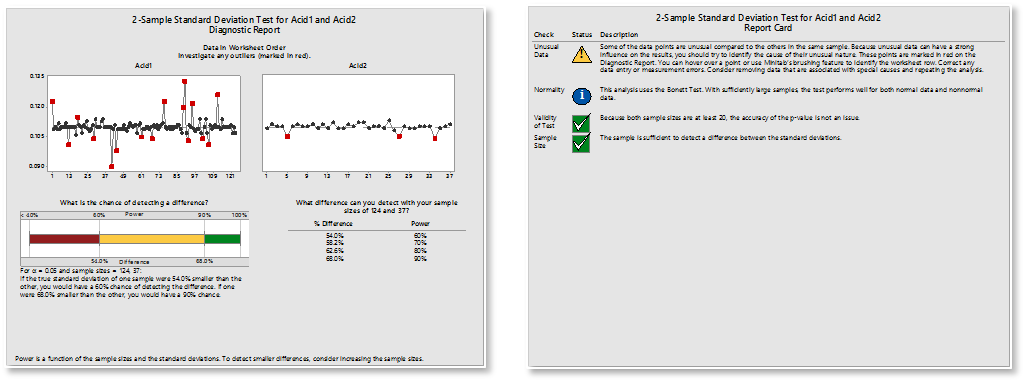

Después de realizar el análisis, verifique el Informe de diagnóstico para la interpretación de la prueba y la Tarjeta de informe para las alertas de puntos de datos inusuales o suposiciones que no se cumplieron. (Consejo: Al realizar la prueba t de 2 muestras y ANOVA, el Asistente adopta un enfoque más conservador y utiliza cálculos que no dependen de la suposición de la misma varianza).

La verdadera razón por la que se necesitan verificar las suposiciones

Se dedica mucho tiempo y esfuerzo a recopilar y analizar datos. Después de todo el trabajo que se ha puesto en el análisis, es deseable poder llegar a conclusiones correctas. Algunos análisis son robustos a los alejamientos de estas suposiciones, ¡pero tome la ruta segura y verifique! ¡Se quiere estar seguro de poder decir si las diferencias observadas entre las muestras de datos se deben simplemente al azar, o si las poblaciones son realmente diferentes!

Es fácil colocar el carro antes que el caballo y simplemente sumergirse en la recopilación y análisis de datos, pero es mucho más inteligente tomarse el tiempo para comprender qué suposiciones de datos se aplican a las pruebas estadísticas que se usarán y planificar en consecuencia.

En la próxima publicación se revisarán las suposiciones comunes sobre la estabilidad y el sistema de medición.

- Detalles

- Categoría: Twinn Witness

- Visto: 8023

Por Mandy Tague

Hoy en día se habla de la Industria 4.0 en todas partes. Si tiene preguntas, inquietudes o temores sobre cómo comenzar su viaje a la transformación digital y cómo tener éxito, no está solo. El 75% de los encuestados en el Informe Anual de Manufactura 2017 dijo que no comprendía las implicaciones de la Industria 4.0. Esta incertidumbre se menciona como una de las razones principales por las que algunas empresas son reacias a comprometerse completamente a avanzar en las iniciativas de la Industria 4.0.

A continuación, se describen los 6 pasos para que la industria 4.0 sea un éxito, a tener en cuenta a medida que se empieza el viaje a la transformación digital.

1. Crear un gemelo digital

Un gemelo digital es una réplica de sus activos o procesos. Entendiendo realmente, en primer lugar, su estado actual, estará en una posición de partida mejor para formular y luego responder las preguntas de negocio correctas.

2. Utilice el gemelo digital para impulsar el compromiso de la dirección de alto nivel

La transformación total que está detrás de las iniciativas de Industria 4.0 requiere la involucración completa de gerencia. Las partes interesadas clave deberían participar incluso antes de que se cree el gemelo digital. La naturaleza visual del gemelo es una manera potente de ayudar a todas las partes interesadas a comprender la compleja dinámica de sus operaciones integrales. Un compromiso temprano ayuda a reducir el vértigo que a menudo se produce con un cambio importante.

3. Use el gemelo digital para hacer las preguntas correctas y establecer metas claras

La administración tiende a lanzar recursos a un problema durante una crisis sin una comprensión completa de la complejidad o el contexto de ese problema. El gemelo digital permite una comprensión de alto nivel de cómo se comportan los procesos en diferentes escenarios. Este campo de pruebas virtual permite establecer objetivos realistas desde el principio.

4. Probar y priorizar las opciones de implementación de Industria 4.0

Ahora se encuentra en una posición en la que puede concentrarse en las etapas del proceso y las tecnologías que se prevé tendrán un impacto máximo en el rendimiento empresarial. Es posible que desee considerar crear un gemelo digital más detallado de sus procesos para que pueda probar y experimentar con diferentes inversiones de la tecnología que esté considerando. Esto le permitirá proceder a la implementación con confianza.

5. Desarrollar habilidades, adquirir tecnologías apropiadas e implementar las tecnologías

Con sus inversiones en tecnología priorizadas, ahora debe asegurarse de contar con las habilidades y capacidades apropiadas antes de proceder a la implementación. Esto puede hacerse a través de adquisición o formación y desarrollo. A medida que avanza en la implementación, el gemelo digital se debe utilizar para rastrear el valor entregado en comparación con los objetivos y metas establecidos anteriormente. Esto mantendrá la implementación en curso y maximizará los retornos de forma continua.

6. Pasar de la mejora continua a la innovación continua

El viaje a la Industria 4.0 no tiene fin, dado su objetivo de mejorar continuamente la agilidad operativa. Las técnicas tradicionales de mejora continua se basan en datos históricos y análisis de procesos tradicionales. En cambio, las empresas deben anticipar los diferenciadores de rendimiento innovadores del mañana y actuar antes que los demás. Esta es la era de la innovación continua.

Para obtener una guía más detallada y una discusión sobre los desafíos que enfrentan quienes inician su recorrido a la Industria 4.0, descargue el documento ejecutivo de Lanner 'Industry 4.0: Using Simulation and the Predictive Digital Twin to Support Success Transformation Digital' por el COO Andrew Aitken.