- Detalles

- Categoría: Minitab

- Visto: 184959

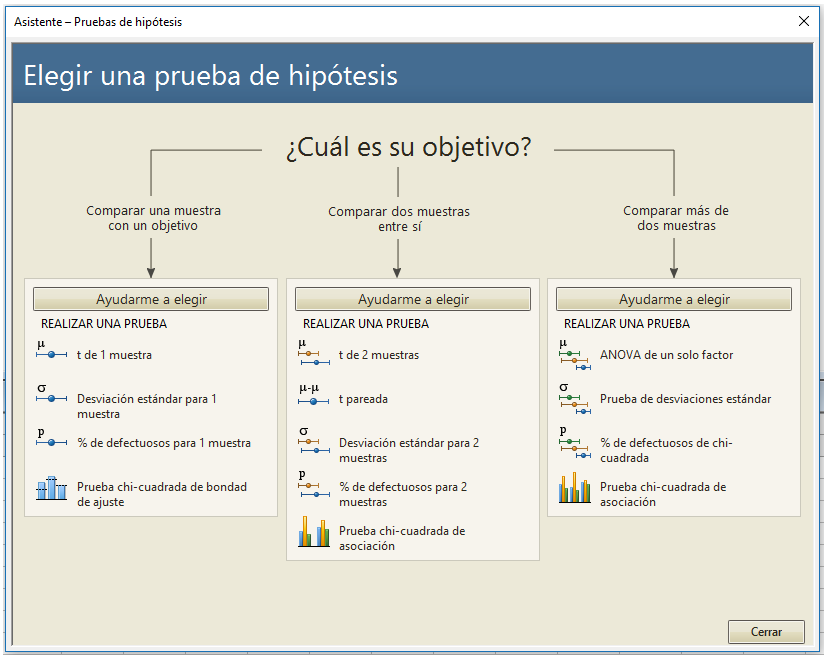

En esta publicación se muestra cómo funcionan las pruebas de hipótesis y los intervalos de confianza, centrándose en conceptos y gráficos en lugar de las ecuaciones y números.

Previamente se había utilizado gráficos para mostrar lo que realmente significa significación estadística. Pero en esta publicación se explicarán tanto los intervalos de confianza como los niveles de confianza, y cómo están estrechamente relacionados con los valores de P y los niveles de significación.

Cómo interpretar correctamente los intervalos de confianza y los niveles de confianza

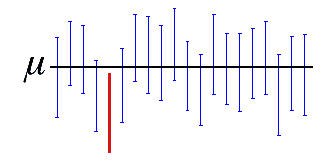

Un intervalo de confianza es un rango de valores que es probable que contenga un parámetro de población desconocido. Si se dibuja una muestra aleatoria muchas veces, un cierto porcentaje de los intervalos de confianza contendrá a la media de la población. Ese porcentaje es el nivel de confianza.

Con mayor frecuencia, se utilizarán los intervalos de configanza para delimitar la media o la desviación estándar, pero también pueden obtenerse para los coeficientes de regresión, las proporciones, las tasas de incidencia (Poisson) y las diferencias entre poblaciones.

Un intervalo de confianza del 95% indica que 19 de cada 20 muestras (95%) de la misma población producirá intervalos de confianza que contienen el parámetro de la población.

Del mismo modo que hay una idea errónea de cómo interpretar los valores de P, también hay una idea errónea de cómo interpretar los intervalos de confianza. En este caso, el nivel de confianza no es la probabilidad de que un intervalo de confianza específico contenga el parámetro de población.

El nivel de confianza representa la capacidad teórica del análisis para producir intervalos precisos si se es capaz de calcular muchos intervalos y conoce el valor del parámetro de población. Para un intervalo de confianza específico de un estucio, el intervalo contiene el valor de la población o no, no hay posibilidad de que existean probabilidades diferentes de 0 o 1. Y no se puede elegir entre estas dos posibilidades porque no se conoce el valor del parámetro de población.

"El parámetro es una constante desconocida y no se puede hacer una afirmación de probabilidad respecto su valor." —Jerzy Neyman, desarrollador original de los intervalos de confianza.

Esto se comprenderá más fácilmente después de que hablemos de la gráfica más abajo...

Con esto en mente, ¿cómo se interpretan los intervalos de confianza?

Los intervalos de confianza sirven como buenas estimaciones del parámetro de población porque el procedimiento tiende a producir intervalos que contienen el parámetro. Los intervalos de confianza se componene de la estimación puntual (el valor más probable) y un margen de error en torno a esa estimación puntual. El margen de error indica la cantidad de incertidumbre que rodea la estimación muestral del parámetro de población.

En este sentido, pueden utilizarse los intervalos de confianza para evaluar la precisión de la estimación de la muestra. Para una variable específica, uni intervalo de confanza más estrecho [90 110] sugiere una estimación más precisa del parámetro de población que un intervalo de confianza más amplio [50 150].

Intervalos de confianza y el margen de error

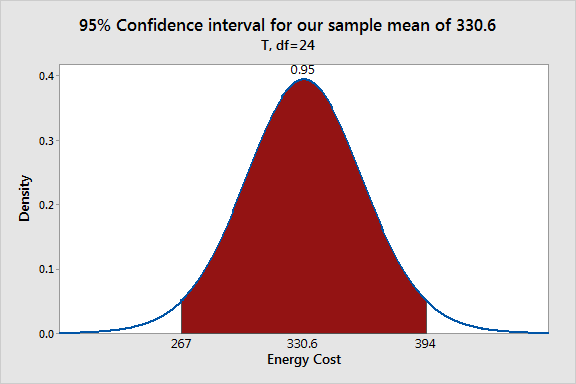

Continuemos para ver cómo los intervalos de confianza explican ese margen de error. Para hacer esto, utilizaremos las mismas herramientas que hemos estado usando para entender las pruebas de hipótesis. Se creará una distribución de muestreo utilizando gráficos de distribución de probabilidad, la distribución t y la variabilidad en los datos. Basaremos el intervalo de confianza en el conjunto de datos de costes de energía que se han estado utilizando.

Cuando observamos los niveles de significación, los gráficos mostraban una distribución muestral centrada en el valor de la hipótesis nula, y el 5% exterior de la distribución estaba sombreado. Para los intervalos de confianza, necesitamos desplazar la distribución del muestreo para que esté centrada en la media de la muestra y sombrear el 95% central.

Gráfico de distribución de probabilidad que ilustra cómo funcionan los intervalos de confianza

El área sombreada muestra el rango de la muestra que significa que se obtendría el 95% del tiempo utilizando nuestra media muestral como la estimación puntual de la media poblacional. Este rango [267 394] es nuestro intervalo de confianza del 95%.

Utilizando el gráfico es más fácil comprender cómo un intervalo de confianza específico representa el margen de error, o la cantidad de certeza, alrededor de la estimación puntual. La media muestral es el valor más probable para lamedia poblacional dada la información que tenemos. Sin embargo, el gráfico muestra que no sería totalmente inusual que otras muestras aleatorias extraídas de la misma población obtuvieran diferentes medias muestrales dentro del área sobreada. Estas otras muestras probables significan que todos sugiere valores diferentes para la media de la población. Por lo tanto, el intervalo representa la incertidumbre inherente que viene con el uso de datos de muestra.

Se pueden utilizar estos gráficos para calcular probabilidades para valores específicos. Sin embargo nótese que no se puede posicionar la media de la población en el gráfico porque el valor es desconocido. En consecuencia, no se pueden calcular probabilidades para la media de la población, ¡tal y como dijo Neyman!

Por qué los valores de P y los intervalos de confianza siempre concuerdan con la significación estadística

Se puede utilizar valores de P o intervalos de confianza para determinar si los resultados son estadísticamente significativos. Si una prueba de hipótesis produce ambos, estos resultados concordarán.

El nivel de confianza es equivalente a 1 - el nivel alfa. Entonces, si el nivel de significación es 0.05, el nivel de confianza correspondiente es del 95%.

- Si el valor de P es menor que su nivel de significación (alfa), la pruebas de hipótesis es estadísticamente significativa

- Si el intervalo de confianza no contiene el valor de la hipótesis nula, los resultados son estadísticamente significativos.

- Si el valor de P es menor que alfa, el intervalo de confianza no contendrá el valor de hipótesis nula.

Para nuestro ejemplo, el valor de P (0.031) es menor que el nivel de significancia (0.05), lo que indica que nuestro resultado es estadísticamente significativo. De manera similar, nuestro intervalo de confianza del 95% [267 394] no incluye la media de la hipótesis nula de 260 y llegamos a la misma conclusión.

Para comprender por qué los resultados siempre concuerdan, recuérdese como funcionan tanto el nivel de significación como el nivel de confianza.

- El nivel de significación define la distancia que la media de la muestra debe estar de la hipótesis nula para que se considere estadísticamente significativa.

- El nivel de confianza define la distancia para lo cerca que están los límites de confianza de la media de la muestra.

Tanto el nivel de significación como el nivel de confianza definen una distancia de un límite a una media. ¿Adivina? ¡Las distancias en ambos casos son exactamente iguales!

La distancia es igual al t-valor crítico * el error estándar de la media. Para los datos del ejemplo del coste de la energía, la distancia llega a ser de 63.57$.

Imagine esta discusión entre la media de la hipótesis nula y la media de la muestra:

- Media de la hipótesis nula, representante de la prueba de hipótesis: ¡Hola amigo! Descubrí que eres estadísticamente significativo porque estás a más de 63,57$ de mi.

- Media de la muestra, representante del intervalo de confianza: En realidad yo soy significativo porque tú estás a más de 63,57$ de mi!

Muy agradables, ¿verdad? Y, siempre estarán de acuerdo mientras se comparen los correctos pares de P valores e intervalos de confianza. Si se comparan los pares incorrectos, se obtendrán resultados conflictivos, como se muestra en el error típico #1 en esta publicación.

Pensamientos finales

Los análisis estadísticos, tienden a centrarse más en los P valores y simplemente detectar un efecto o diferencia significativos. Sin embargo, un efecto estadísticamente significativo no es necesariamente significativo en el mundo real. Por ejemplo, el efecto puede ser demasiado pequeño para tener algún valor práctico.

Es importante prestar atención tanto a la magnitud como a la precisión del efecto estimado. Por eso me gustan los intevalos de confianza. Permiten evaluar estas importantes características junto con la significación estadística. A todos nos gustaría ver un intervalo de confianza estrecho donde el rango completo representa un efecto que es significativo en el mundo real.

- Detalles

- Categoría: Maple

- Visto: 10964

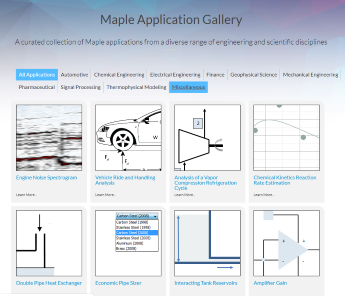

Maplesoft pone a disposición de los usuarios de sus herramientas Maple y MapleSim un gran número de recursos para el aprendizaje y el aprovechamiento del trabajo realizado por otros usuarios. Además de sitios comunitarios como Maple Cloud y Maple Primes, también está disponible la Maple Application Gallery, una colección filtrada de aplicaciones de Maple libres, sobre un diverso rango de disciplinas científicas y de ingeniería.

Las aplicaciones se dividen en las siguientes áreas:

- Automoción

- Ingeniería química

- Ingeniería eléctrica

- Finanzas

- Ciencias geofísicas

- Ingeniería mecánica

- Farmacia

- Procesado de señal

- Modelado termofísico

- Misceláneos

- Detalles

- Categoría: Comsol

- Visto: 13263

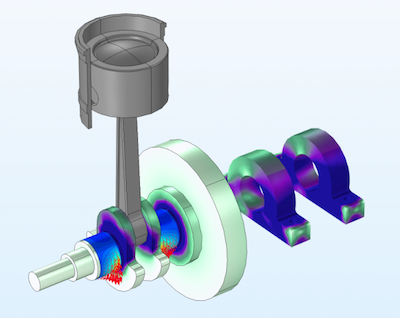

Varios tipos de máquinas, como motores, bombas y turbinas, utilizan componentes que transmiten la carga entre las partes sólidas que están en movimiento relativo. Los ejemplos más típicos son los aros del pistón, levas, dientes de engranajes y, por supuesto, los cojinetes. A menudo estos componentes se lubrican manteniendo una película de aceite entre las dos partes sólidas para minimizar la fricción y el desgaste. En esta publicación del blog de COMSOL, Prashant Srivastava analiza los métodos para modelar la fricción del fluido en uniones lubricadas.

Tras presentar los diferentes regímenes de lubricación, el autor se centra en los regímenes de lubricación de película completa, porque las juntas forman superficies conformes y la presión no es lo suficientemente alta como para causar una deformación significativa.

Continúa con el cálculo teórico de la fuerza de arrastre viscosa entre las placas separadas por un lubricante y determina la fuerza viscosa en juntas lubricadas para acabar explicando cómo se modelan las juntas lubricadas utilizando COMSOL Multiphysics, y mostrando un ejemplo de fricción fluida en las juntas y otro de un motor recíproco con rodamientos hidrodinámicos.

- Detalles

- Categoría: Comsol

- Visto: 10637

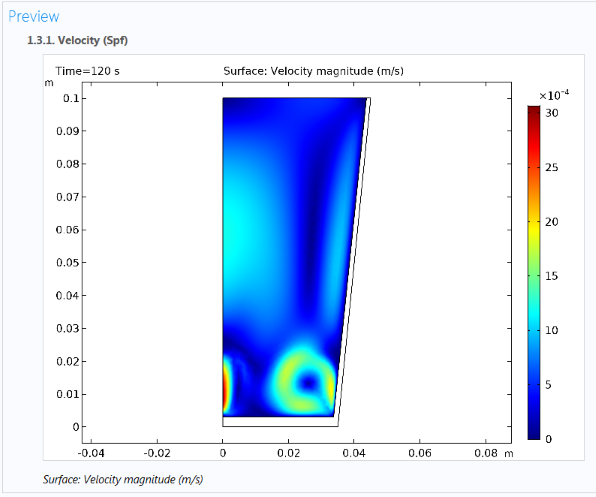

Los informes son muy valiosos para documentar y mostrar resultados de nuestras simulaciones. A partir de la versón 5.4, el software COMSOL Multiphysics® incluye el soporte para utilizar plantillas de informes, lo que puede ser utilizado para crear informes a medida. En este post del blog de COMSOL, Magnus Ringh describe cómo añadir plantillas de informes y muestra algunos ejemplos de cómo pueden ser de utilidad para crear informes con disposiciones y contenidos específicos.

Informe de los resultados de la simulación

Crear informes a partir de las simulaciones de COMSOL Multiphysics proporciona una manera de documentar los justes y resultados de la simulación. Los informes también posibilitan la distribución de información a partir de simulaciones a una audiencia más amplia. Pueden crearse informes en dos formatos:

- HTML: El formato HTML es apropiado para visualizar un informe en un navegador web. Se puede personalizar la disposición utilizando una hoja de estilo (archivo CSS) a su elección.

- Microsoft Word: Este formato es adecuado para imprimir y para ampliar el informe con texto e información adicional. La disposición del documento Word puede controlarse utilizando una plantilla de Microsoft® Word personalizada (archivo *.dotx).

Hasta la versión 5.4 de COMSOL Multiphysics, han habido tres plantillas predefinidas diferentes o niveles para los contenidos de un informe:

- Breve: Un informe breve contiene una visión general del modelo con todos los resultados y gráficos pero sin detalles sobre las interfaces físicas, los ajustes del resolvedor o las variables.

- Intermedio: Un informe intermedio contiene información detallada sobre el modelo, incluyendio los ajustes y variables de la interfaz física, pero no dispone de información completa, por ejemplo, sobre las ecuaciones subyacentes.

- Completo: Un informe completo contiene información exhaustiva sobre el modelo, incluyendo los detalles de la interfaz física como expresiones de la ecuación débil y funciones de forma.

Estas plantillas predefinidas proporcionan diferentes niveles de detalle, pero todos informan sobre cada uno de los aspectos de su proyecto de simulación. Además, se puede crear una plantilla a medida, que inicialmente está vacía, de forma que puede ser configurada libremente utilizando los componentes de informes disponibles.

Lea la entrada completa en el blog de COMSOL para conocer los detalles sobre los informes a medida y un par de ejemplos prácticos.

- Detalles

- Categoría: Minitab

- Visto: 39475

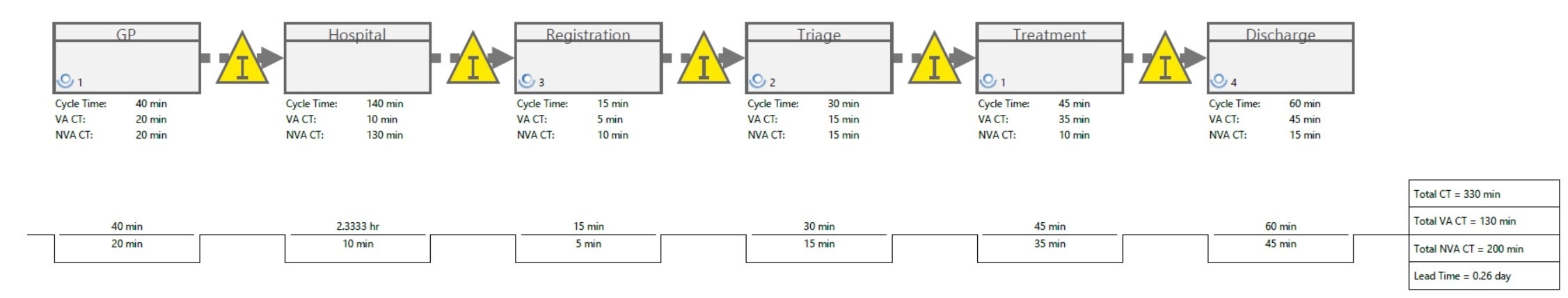

En el mundo sanitario podemos encontrar muchas actividades cuyos datos pueden ser usados para mejorar los tiempos de ciclo, la satisfacción de los clientes, los tiempos de espera, la capacidad de las plantas y el inventario.

Haciendo honor a la Semana de Calidad Sanitaria y al Mes de Calidad Nacional (octubre) llevados a cabo en Estados Unidos, y al mes de Calidad Mundial, el objetivo de este artículo es compartir las capacidades principales de los Mapas de Flujo de Valor (comúnmente conocido como VSM, por sus siglas en inglés). Los mapas de flujo de valor pueden ayudar a plantear el mapa, visualizar y entender el flujo de pacientes, materiales e información.

Se denomina cadena de valor a todas las actividades requeridas para completar un proceso particular, y el objetivo de los VSM es identificar mejoras que pueden ser llevadas a cabo para reducir el gasto, como puede ser, por ejemplo, el tiempo de espera de los pacientes.

¿Cómo son los Mapas de la cadena de valor aplicados a la sanidad?

Cuando aplicamos los VSM a la sanidad, uno de los principales enfoques es su uso para plasmar el flujo del paciente hasta su tratamiento, para mejorar los servicios y la calidad de atención y minimizar retrasos.

Para plantear el sistema de manera adecuada, la clave reside en buscar información fiable y de calidad acerca del flujo de información y el tiempo que el paciente pasa en alguna etapa o entre distintas etapas. Es esencial la toma de datos de tiempo precisos y el uso de equipos de distintos departamentos que puedan contrastar datos.

Para realizar el mapa del tratamiento de un paciente, lo ideal será crear un mapa de estado presente con VSM (una de las herramientas principales de Companion by Minitab), para que nos sirva de guía para identificar las áreas donde procede realizar alguna mejora.

En el ejemplo de la imagen superior, la primera etapa por la que pasa el paciente es la visita al médico general (en el VSM: “GP”, de General Physician), y esto es representado con un proceso con forma rectangular en el VSM. El tiempo que el paciente está en este paso puede ser resumido en los tiempos de ciclo de Valor Añadido (VA) y No Valor Añadido (NVA). VA es el tiempo que el paciente está dispuesto a esperar sin percibir demora alguna, en este caso 20 minutos en la consulta del doctor. NVA es el tiempo que el paciente ya percibe una demora, en este caso 20 minutos en la sala de espera.

La línea de puntos entre los procesos muestra que una vez que el paciente acaba de pasar por una etapa, es enviado directamente a la siguiente. Muchas veces no se adapta a la realidad del proceso, ya que hay tiempos de espera entre las distintas etapas. Estos tiempos de espera (el tiempo que el paciente está esperando a ser recibido en la siguiente consulta) se representan con triángulos amarillos. Son procesos intermedios considerados como “NVA” (procesos de valor no añadido) para el paciente, ya que suponen una percepción de demora.

Si bien es cierto que los VSM pueden ser creados sobre papel, el uso de herramientas informáticas como Companion by Minitab, nos facilita y agiliza el trabajo. Como podemos ver en la siguiente captura parcial, Companion calcula y muestra automáticamente una línea temporal en la parte inferior al VSM, que va sumando el tiempo total a través de todo el proceso (denominado “lead time” o tiempo de espera) y muestra la información temporal de cada proceso y del proceso global.

Identificando todas estas etapas se puede empezar a plantear el mapa de todo el proceso. Una vez se ha creado el mapa del estado presente con todas las etapas correctamente definidas, puede procederse a la creación del mapa de estado futuro, añadiendo o eliminando etapas o tiempos entre ellas. Este mapa de estado futuro permite identificar áreas de mejora, y una vez haya sido implementado, será el nuevo mapa de estado presente, de manera que formará parte del proceso global de mejora.

¿Cómo mejorar el mapa de estado presente?

Cuando se buscan áreas de mejora, el objetivo es enfocar los cambios en la mejora del flujo de pacientes durante el proceso: el estado ideal es el flujo continuo de los pacientes por todo el proceso. El flujo continuo mueve a los pacientes a través del sistema sin que tengan que esperar. A pesar que el flujo continuo puede no ser posible, puesto que en sanidad entran en juego muchos factores, una serie de herramientas nos pueden ayudar a introducir otros cambios: por ejemplo el FIFO (primero en entrar, primer en salir) puede ser aplicable a consultas de extracción de sangre.

Es importante también tener en consideración el takt time (tiempo medio entre el inicio de una actividad y el inicio de la siguiente), ya que puede ayudar a estudiar el comportamiento del paciente. Podemos interpretar el takt time, en este caso, como el número de pacientes que pueden ser atendidos por unidad de tiempo. Companion by Minitab calcula este dato de manera automática.

Una vez se hayan completado tanto el mapa de estado presente como el de estado futuro, podrán compararse los dos, cuantificar la mejora de oportunidades, y estudiar cómo implementar los cambios. En este ejemplo, se propone que el protocolo de intervención y clasificación y los pasos relativos a la cita se realicen de manera conjunta, ya que combinados supondrán menos visitas al hospital por parte del paciente, y una percepción de mejora.

A continuación se ilustra, de manera resumida, cómo sería el proceso de realización de un Value Stream Map con Companion by Minitab:

- Detalles

- Categoría: Otras

- Visto: 8372

A medida que los proveedores de medicamentos se esfuerzan por crear fármacos basados en proteínas eficaces, la inmunogenicidad sigue siendo un desafío complejo. La inmunogenicidad no deseada es un tema candente hoy en día, en parte porque todavía no se comprende por completo.

Ir lejos, ir juntos

La tasa de desgaste es un problema recurrente en la industria farmacéutica. Un proceso que genera miles de moléculas en la fase de investigación generalmente concluye con solo unos pocos productos terapéuticos viables. Esto aumenta el coste de llevar nuevos medicamentos al mercado, lo que hace que los pacientes paguen precios más altos por los medicamentos que necesitan.

Esto pretende solucionarse con herramientas predictivas, estas se basan en algoritmos establecidos que se han validado a lo largo del tiempo. No es difícil para los analistas estadísticos construir modelos predictivos, pero el grado en que se puede confiar en la respuesta de un modelo depende de qué datos se utilizan. Las plataformas seguras de terceros podrían permitir recopilar y centralizar datos biológicos de las organizaciones participantes para crear modelos predictivos. Los datos estarían protegidos, por lo que las empresas solo tendrían acceso a los datos que proporcionan mientras se benefician del conocimiento colectivo de todos los contribuyentes. Tal estrategia puede mejorar la precisión científica para toda la industria y reducir el coste de los medicamentos para los pacientes, todos ganan.

Iniciativas como la Alianza Pistoia y la Fundación Allotrope son precedentes exitosos para este tipo de cooperación entre organizaciones de ciencias de la vida. En estos proyectos, los expertos de las compañías de ciencias de la vida y otros grupos se reúnen para compartir estrategias precompetitivas y establecer un formato de datos y una ontología comunes para la industria.

Consigamos que funcione

Una vez realizados los estudios previos utilizando herramientas de predicción, cuando los investigadores descubren un fármaco candidato que tiene el potencial de curar a un gran porcentaje de la población de pacientes, no lo descartan si los estudios revelan inmunogenicidad. Hoy en día es más común buscar formas de disminuir la inmunogenicidad sin afectar la eficacia del tratamiento. ¿Podemos definir una terapéutica como exitosa cuando el diez, cinco o cero por ciento de la población muestra una respuesta inmunogénica? ¿Qué nivel de inmunogenicidad es aceptable?

La perspectiva lo es todo

La ciencia trata de reproducir resultados. Cuando una empresa desarrolla un medicamento, se deben registrar todos los experimentos y pruebas. Las organizaciones deben poder demostrar a los organismos reguladores - como la Administración de Medicamentos y Alimentos (FDA) de EE. UU, - que los resultados de desarrollo son reproducibles. Por lo tanto, es importante que las reglas estén claramente definidas y se cumplan para experimentos virtuales (como los realizados mediante herramientas predictivas), experimentos de laboratorios y todos los datos asociados. El desafío es mantener esos datos para que el modelo y sus resultados sean reproducibles en el futuro.

Los datos utilizados en investigación deben ser completos, coherentes, correctos y contextualizados. Los trabajadores deben, además, asegurar que la información utilizada no se modifique respecto a la original. Deben existir procedimientos para el control de los datos, para garantizar que se gestionen de manera adecuada. La gestión adecuada del ciclo de vida de los experimentos virtuales, los experimentos de laboratorio y todos los datos asociados son tan importantes como los resultados de los experimentos. Esto, como se comentó al principio, puede suponer que el ciclo de vida de un proceso de investigación farmacológica sea mayor o menor, siempre en función de las herramientas empleadas.

Como alinear experimentos virtuales y reales

A medida que los expertos se esfuerzan por desarrollar terapias exitosas para poblaciones de pacientes cada vez más personalizadas, la colaboración efectiva y la cooperación precompetitiva pueden ayudarlos a predecir la inmunogenicidad con mayor precisión. Los profesionales de la industria necesitan soluciones que permitan la reproducibilidad de los resultados experimentales, impongan la integridad de los datos y ofrezcan entornos de trabajo que sean fácilmente accesibles para personas con una amplia gama de experiencia. Se busca equipar con estándares y protocolos que consideren que los experimentos virtuales y reales son socios equitativos en el desarrollo de productos bioterapéuticos. Los científicos podrán tomar mejores decisiones e identificar antes las respuestas inmunitarias potenciales.

Y usted, ¿qué método utiliza para mejorar su rendimiento y, con él, la obtención de mejores resultados? Pregúntenos si quiere más información sobre los métodos de los que disponemos.

- Detalles

- Categoría: Comsol

- Visto: 4248

Con la potencia computacional y del software disponible hoy en día, la simulación numérica se ha convertido en una opción para obtener rápidamente respuestas a preguntas técnicas, científicas y de ingeniería complicadas. No sólo ha sido el hardware el que ha doblado su capacidad de cálculo aproximadamente cada 18 meses durante las últimas décadas, sino que los algoritmos han ido mejorando con la misma tasa.

Los modelos multifísicos precisos consideran un amplio abanico de posibles condiciones de trabajo y efectos físicos. Esto posibilita el uso de modelos para comprender, diseñar y optimizar procesos y dispositivos para condiciones operativas realistas. Habilitados por estos modelos multifísicos de los productos que desean diseñar y una cultura de colaboración con la conveniencia de las aplicaciones de simulación, los diseñadores e ingenieros están ampliando los límites de la tecnología al tiempo que reducen la necesidad de prototipos físicos, lo que se traduce en mejores soluciones empresariales y de ingeniería para todos en la empresa.