- Detalles

- Categoría: Minitab

- Visto: 2165

Por Cody Steele.

Si ha realizado o planea realizar un trabajo de mejora de procesos, probablemente se habrá preguntado si realmente está obteniendo mediciones lo suficientemente precisas. Debe confiar en sus datos antes de utilizarlos para tomar decisiones críticas sobre ajustes y asignación de recursos. El análisis de sistemas de medición (MSA) se refiere en términos generales a los procedimientos que estiman y evalúan la cantidad de variación en un sistema de medición. Un tipo de estudio es el EMP, también conocido como método de Wheeler. EMP viene del inglés "Evaluate Measurement Process". El estudio EMP evalúa dos fuentes de variación de medición:

- Repetibilidad: La variación que se observa cuando un mismo operador mide la misma pieza muchas veces, utilizando el mismo calibre, en las mismas condiciones.

- Reproducibilidad: La variación que se observa cuando diferentes operadores miden la misma pieza muchas veces, usando el mismo calibre, en las mismas condiciones.

|

|

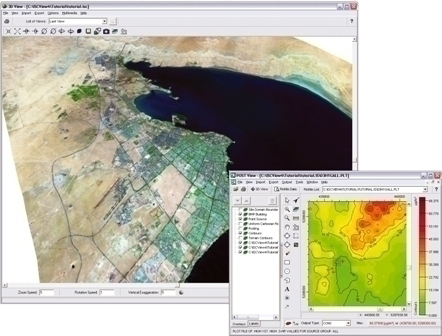

Basado en la repetibilidad y reproducibilidad, el estudio EMP clasifica los sistemas de medición que van desde la mejor calificación de Primera Clase hasta la peor calificación de Cuarta Clase. En términos prácticos, estas clases explican qué tan bien el sistema de medición detecta un cambio en la media del proceso de al menos 3 desviaciones estándar. Si el sistema de medición puede detectar cambios como estos, entonces el sistema de medición debería ser útil para otras actividades de mejora de procesos. Por ejemplo, muchos gráficos de control utilizan una media de subgrupo de más de 3 desviaciones estándar de la media general como señal de que una causa especial afectó el proceso. Por ejemplo, un fabricante de alimentos de consumo controla el peso de llenado de las cajas de cereales. El fabricante quiere asegurarse de que la variación de diferentes mediciones sea lo suficientemente pequeña como para poder utilizar otros análisis de mejora de procesos. Los resultados de un estudio EMP ayudan a determinar si el sistema de medición es aceptable y cómo mejorarlo. |

¿ES ACEPTABLE EL SISTEMA DE MEDICIÓN?

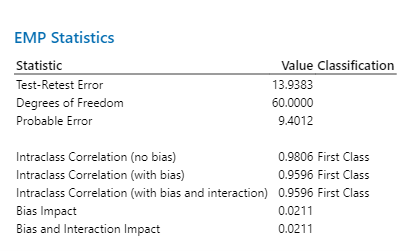

Las estadísticas del EMP proporcionan al sistema de medición su clasificación. En estos resultados, la clasificación es Primera Clase. El equipo puede estar seguro de que el sistema de medición será lo suficientemente bueno como para utilizarlo en otras actividades de mejora de procesos.

¿CÓMO PUEDE MEJORAR EL SISTEMA DE MEDICIÓN?

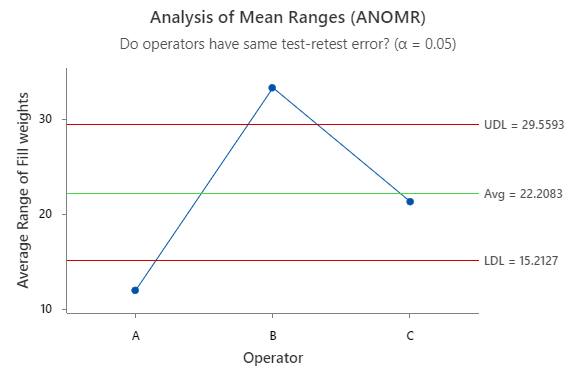

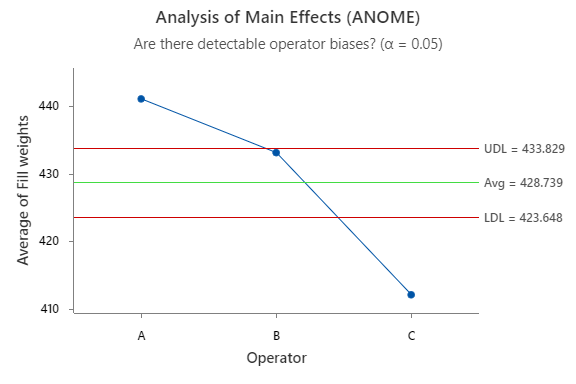

El estudio EMP también incluye información que puede utilizarse para decidir cuándo priorizar las mejoras en el sistema de medición. El Análisis de Rangos Medios (ANOMR) y el Análisis de Efectos Principales (ANOME) muestran dónde la reproducibilidad es baja en relación con la variación del proceso. En este ANOMR, el operador B es menos consistente que los otros dos operadores. Mejorar la coherencia para el operador B mejorará el sistema de medición.

En este ejemplo ANOME, diferentes operadores tienden a medir más alto o más bajo que los demás. Mejoras que acerquen las medidas medias de los distintos operadores mejorarán el sistema de medida.

CONFÍE EN SUS DATOS

Para actuar sobre la base de sus datos, debe confiar en que los datos son correctos. El estudio EMP en Minitab Statistical Software le brinda el poder de ver si su sistema de medición es aceptable y cómo mejorarlo. Cuando evalúa la precisión de sus mediciones, puede tener la confianza de que todo lo que sigue se basa en datos en los que puede confiar.

- Detalles

- Categoría: Comsol

- Visto: 2686

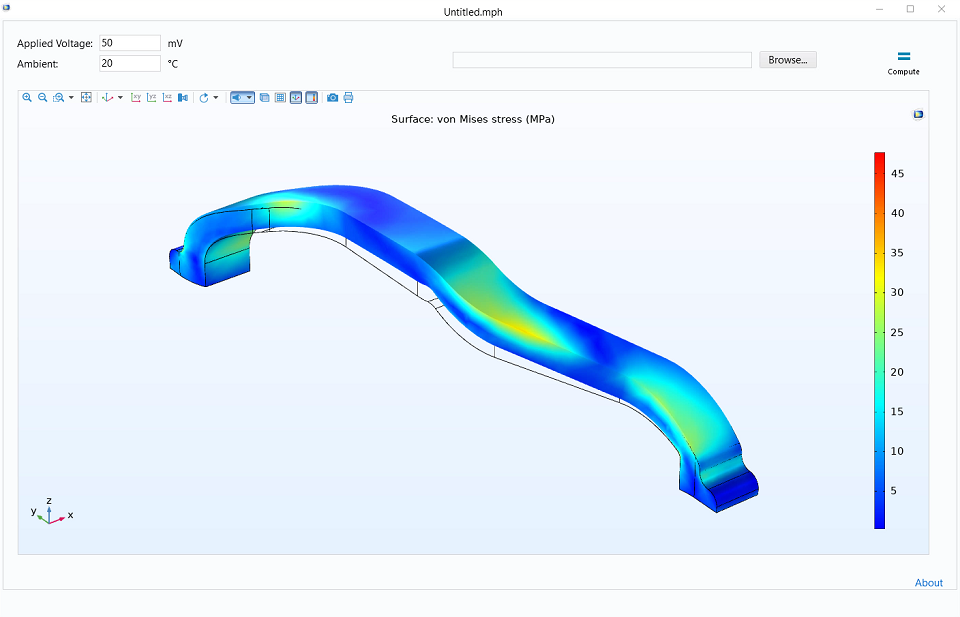

El calentamiento Joule está presente en muchos dispositivos y procesos de ingeniería al producirse el calentamiento de los conductores debido a la corriente que circula por ellos.

El curso "Getting Started with Electro-Thermal-Mechanical Modeling" consta de cinco partes y proporcionna una introducción al uso de COMSOL Multiphysics en el modelado del calentamiento Joule y la expansión térmica.

Vea a continuación las diferentes partes y el índice del curso.

|

|

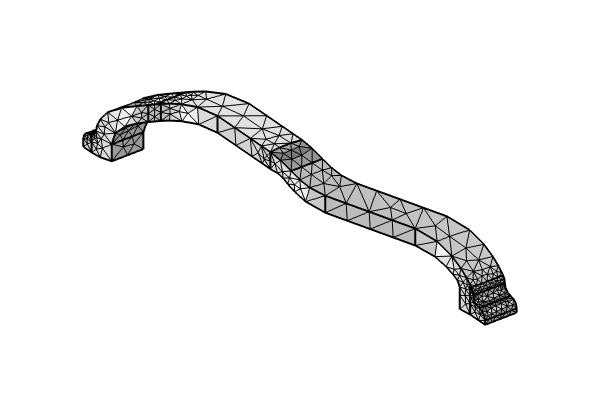

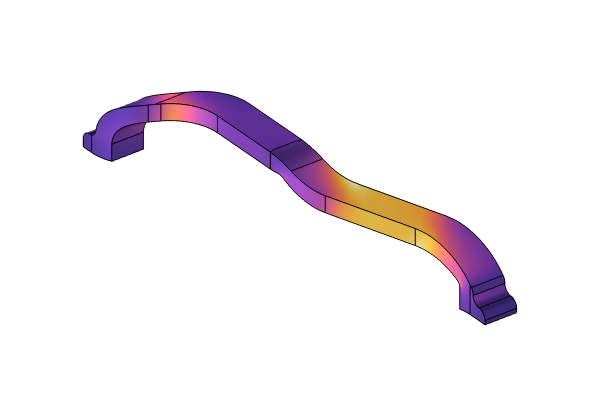

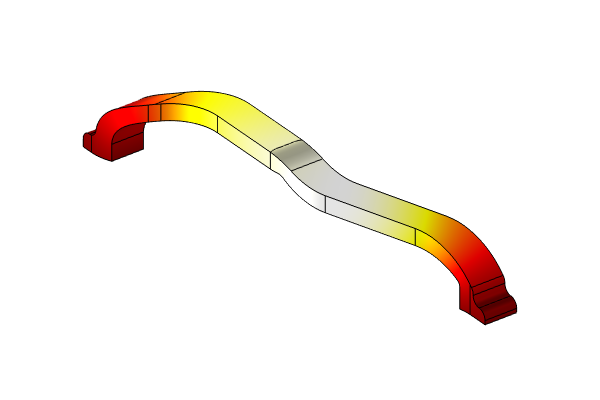

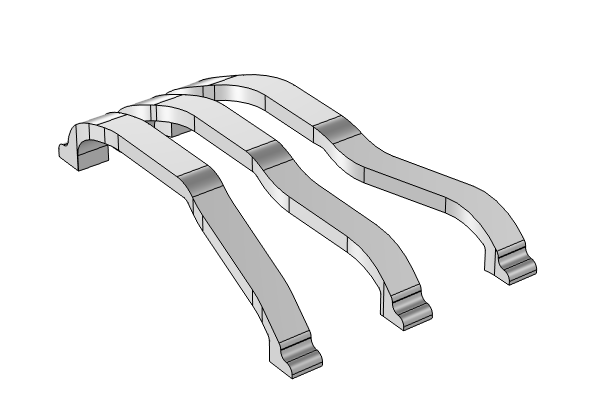

Part 1: Electro-Thermal Mechanical Workflow and CAD Import

|

|

|

Part 2: Performing a Mesh Refinement Study and Using Selections and Variables

|

|

|

Part 3: Evaluating Results and Introducing Nonlinearities in a Current-Driven Model

|

|

|

Part 4: Using the Solver Algorithms and Addressing Modeling Issues

|

|

|

Part 5: Mesh Refinement, CAD Import, and Simulation Apps

|

Al completar el curso, el asistente conseguirá tener una comprensión completa del flujo de trabajo de modelado en el software y tendrá confianza en su propio funcionamiento del software y en la interpretación de los resultados de sus simulaciones.

- Detalles

- Categoría: Maple

- Visto: 1259

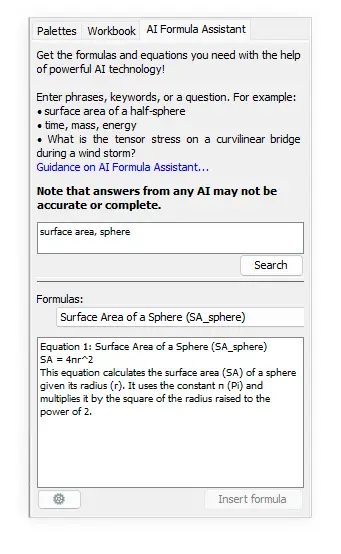

Maple 2024 aprovecha los últimos avances en tecnología de inteligencia artificial para brindarle las fórmulas, ecuaciones, explicaciones y comandos de Maple que necesita.

-

El nuevo AI Formula Assistant le ayuda a encontrar y comprender las fórmulas y ecuaciones. En respuesta a su consulta, ofrece una selección seleccionada de opciones relevantes con explicaciones claras de sus funciones y parámetros. Una vez que haya hecho su selección, puede insertar fácilmente la fórmula elegida como una expresión de Maple en su documento.

-

El paquete NaturalLanguage proporciona comandos que puede utilizar para explorar el uso de modelos de lenguaje grandes, como GPT-4 y ChatGPT de OpenAI, para procesar el lenguaje natural en Maple. ¡Puedes pedirle a la IA que explique un concepto, proporcione detalles adicionales, encuentre un comando de Maple para realizar una tarea específica y más!

- Detalles

- Categoría: Minitab

- Visto: 2123

Por Cheryl Pammer.

Las medidas de capacidad del proceso, como Cpk y Ppk, miden qué tan bien se está desempeñando su proceso en relación con las especificaciones de su cliente. Repasemos algunos conceptos básicos del análisis de capacidad y luego profundicemos en otra estimación de capacidad, Cnpk, que probablemente tenga un lugar muy útil en su arsenal de análisis de capacidad.

Estadísticas de capacidad descomprimidas

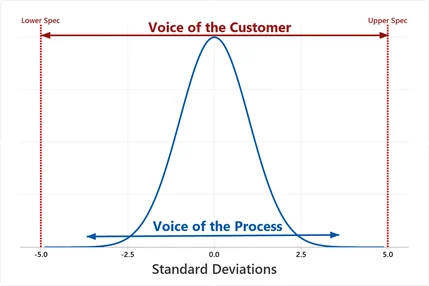

Utilizando un solo número, las estadísticas de capacidad proporcionan una métrica sin unidades para evaluar si un proceso es capaz de cumplir requisitos específicos y para identificar áreas de mejora. Con ese fin, estas estimaciones populares pueden considerarse como la relación entre la “Voz del Cliente” y la “Voz del Proceso”.

Podemos medir fácilmente la “Voz del Cliente”: es la tolerancia aceptable o la distancia entre los límites de las especificaciones. Medir la “Voz del Proceso” es un poco más complicado y a menudo se hace asumiendo que las mediciones provienen de una población con forma de curva de campana. Esto tiene la conveniente propiedad de tener aproximadamente 6 desviaciones estándar de ancho, lo que hace que la “Voz del Proceso” sea aproximadamente 6 veces la desviación estándar.

Si la tolerancia y la extensión del proceso tienen la misma duración, la relación entre la "Voz del Cliente" y la "Voz del Proceso" es aproximadamente igual a 1,0. Sin embargo, lo ideal es que tengamos una especie de zona de amortiguamiento entre nuestras especificaciones y el lugar donde cae el proceso para garantizar defectos mínimos. Por lo tanto, para un proceso con defectos mínimos, la tolerancia debe ser más amplia que la dispersión del proceso, lo que hace que su relación sea mayor que 1. De hecho, los puntos de referencia comunes para estadísticas de capacidad aceptables como Cpk y Ppk son 1,33 y 1,67.

Estadísticas de capacidad en la práctica

Desafortunadamente, las situaciones de la vida real suelen ser más complicadas que este ejemplo de libro de texto. Por ejemplo, a veces solo tenemos un límite de especificación, a menudo la distribución no está centrada entre nuestros límites de especificación y resulta que la desviación estándar se puede medir de más de una manera. Consulte esta discusión para obtener más información sobre estos importantes temas. Además, mientras pensamos en los datos del mundo real, probablemente descubriremos que hay muchas situaciones en las que los datos no siguen la curva en forma de campana de una distribución normal.

En el contexto del Análisis de Capacidad, la forma de los datos es un componente clave de cómo medimos la propagación del proceso. Si los datos se desvían significativamente de la distribución supuesta, métricas como Cpk y Ppk no reflejarán con precisión la capacidad del proceso. Afortunadamente, Minitab Statistical Software incluye un sólido conjunto de herramientas de análisis de capacidad anormal cuando se encuentra con esa molesta situación de datos anormales.

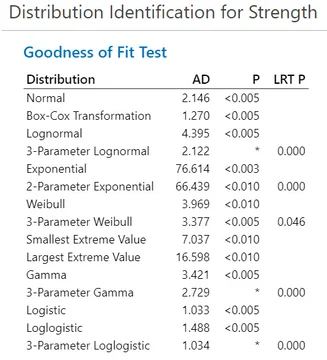

Pero, ¿qué pasa si ya ha probado las opciones probadas y verdaderas para escenarios en los que la distribución normal no encaja? En otras palabras, ¿qué podemos hacer cuando los valores p de Anderson-Darling de Estadísticas > Herramientas de calidad > Identificación de distribución individual están todos por debajo del punto de referencia de 0,05, lo que indica que ninguna de las distribuciones o transformaciones ofrecidas es apropiada?

Cuando las distribuciones/transformaciones alternativas se quedan cortas

Recientemente me encontré con este caso exacto mientras trabajaba con una empresa que fabrica tubos utilizados para dispositivos médicos que brindan soluciones intravenosas. Esta empresa necesitaba demostrar a la Administración de Alimentos y Medicamentos de EE. UU. que sus tubos eran capaces de cumplir con una especificación de resistencia a la tracción establecida.

A continuación se muestran los resultados que obtuve de la Identificación de distribución individual de Minitab Statistical Software.

Cuando se utiliza una prueba de bondad de ajuste de Anderson-Darling, un valor p superior a 0,05 generalmente indica que es apropiado utilizar la distribución o transformación correspondiente al estimar la capacidad. En este caso, sin embargo, ninguno de los métodos cumple ese criterio.

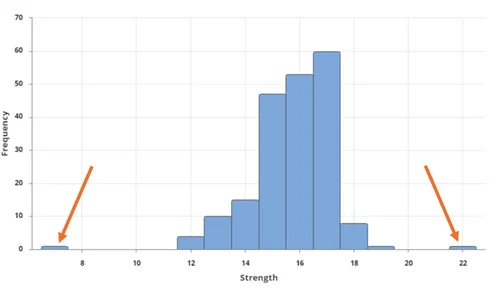

Echemos un vistazo más de cerca a estos datos para ver dónde radica el problema. Usando Graph Builder (Gráfica > Creador de gráficas), puedo ver en el histograma a continuación que una de las piezas de tubo de muestra se rompió con una fuerza menor de la esperada y otra pieza de tubo era más fuerte de lo esperado. Los valores atípicos son la razón más común por la que las distribuciones o transformaciones no ayudan en casos como este. Por definición, un valor atípico extremo no encajará en el patrón general de los datos.

Es importante investigar los valores atípicos extremos e intentar comprender qué los causó. Los valores atípicos pueden ser errores de medición o errores de entrada de datos, en cuyo caso no representan el proceso real y deben ajustarse adecuadamente. Si son valores legítimos, su prioridad número uno debería ser evitar que se produzcan valores atípicos en el futuro y esforzarse por lograr la estabilidad del proceso, pero probablemente aún necesite una estimación de capacidad para sacar su producto al mercado.

Una solución sin distribución para evaluar la capacidad

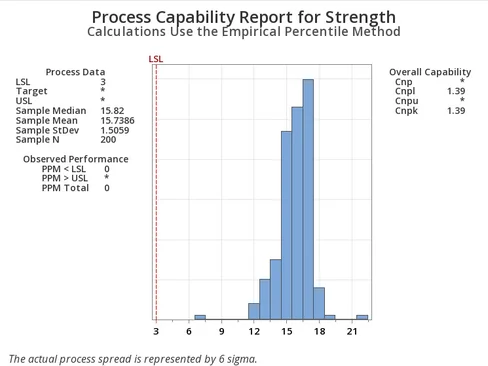

Una de las mejores características nuevas de la versión 22 de Minitab Statistical Software es su análisis de capacidad no paramétrico. Este análisis proporciona una estimación razonable de la capacidad de su proceso sin la suposición más complicada de una distribución. Para acceder a esta útil función, elija Estadísticas > Herramientas de calidad > Análisis de capacidad > No paramétrico.

En el caso de los datos de los tubos médicos, se puede ver que incluso con ese error de dos valores atípicos, el proceso aún era capaz de cumplir con su límite de especificación inferior. Puede interpretar la estadística de capacidad no paramétrica, Cnpk, tal como lo haría con otras estadísticas de capacidad como Cpk y Ppk. En este caso, Cnpk = 1,39, que superó el objetivo de capacidad de la empresa de 1,33.

Los supuestos de distribución son esenciales para el análisis de capacidades porque sustentan los cálculos, interpretaciones, inferencias y decisiones basadas en los resultados del análisis. Sin embargo, también es importante reconocer que es posible que los datos del mundo real no siempre se ajusten perfectamente a estos supuestos. Agregar un método simple y sin distribución a su conjunto de herramientas le permitirá obtener estimaciones de capacidad adecuadas incluso cuando sus datos de la vida real se nieguen a seguir el patrón de cualquier distribución conocida.

- Detalles

- Categoría: Comsol

- Visto: 2755

En el mundo de la ingeniería aerodinámica, la precisión en la simulación del flujo alrededor de perfiles aerodinámicos es fundamental para el diseño eficiente de aeronaves y componentes relacionados. En la librería de aplicaciones de COMSOL se encuentra el ejemplo Flow Around an Inclined NACA 0012 Airfoil [1] El modelo simula el flujo alrededor de un perfil aerodinámico NACA 0012 inclinado a diferentes ángulos de ataque utilizando el modelo de turbulencia SST. Los resultados muestran una buena concordancia con los datos experimentales.

En este contexto, presentamos un estudio realizado por Z. M. Malikov, M. E. Madaliev, S. L. Chernyshev y A. A. Ionov, publicado en Nature Scientific Reports, que destaca la importancia de la validación de un modelo de turbulencia en COMSOL Multiphysics para este propósito crucial [2].

Los autores se han centrado en validar un modelo de turbulencia de dos fluidos en COMSOL Multiphysics para simular el flujo alrededor de perfiles aerodinámicos. Este modelo es esencial para capturar con precisión los fenómenos de turbulencia que ocurren en estas aplicaciones.

Utilizando COMSOL Multiphysics como herramienta de simulación, los autores desarrollaron y resolvieron el modelo de dos fluidos. Luego, compararon los resultados de las simulaciones con datos experimentales y/o soluciones numéricas de referencia para validar la precisión del modelo.

Los resultados obtenidos de la comparación entre las simulaciones y los datos de referencia demuestran la capacidad del modelo de turbulencia en COMSOL Multiphysics para simular con precisión el flujo alrededor de perfiles aerodinámicos. Esto valida su utilidad como una herramienta confiable para investigaciones futuras en el campo de la ingeniería aerodinámica.

El estudio destaca la importancia de utilizar herramientas de simulación precisas y confiables, como COMSOL Multiphysics, en la ingeniería aerodinámica. La validación exitosa de este modelo de turbulencia abre nuevas oportunidades para investigaciones más avanzadas en el diseño y la optimización de aeronaves y componentes relacionados.

En resumen, la validación de un modelo de turbulencia en COMSOL Multiphysics para el flujo alrededor de perfiles aerodinámicos subraya el papel crucial de esta plataforma en la ingeniería aerodinámica. COMSOL Multiphysics se destaca como una herramienta confiable para la simulación de fenómenos complejos en una amplia gama de aplicaciones ingenieriles.

Referencias

[1] Galería de aplicaciones de COMSOL: Flow Around an Inclined NACA 0012 Airfoil

[2] Malikov, Z.M., Madaliev, M.E., Chernyshev, S.L. et al. Validation of a two-fluid turbulence model in comsol multiphysics for the problem of flow around aerodynamic profiles. Sci Rep 14, 2306 (2024). https://doi.org/10.1038/s41598-024-52673-5

- Detalles

- Categoría: Lakes

- Visto: 763

La EPA de EE. UU. exige el uso de AERMOD en diversas aplicaciones regulatorias, centrándose en la evaluación de la calidad del aire y el cumplimiento de las normas. Las regulaciones clave incluyen:

- Programas de revisión de nuevas fuentes (NSR) y prevención de deterioro significativo (PSD):

a. AERMOD se utiliza para permisos que garantizan que las instalaciones propuestas no dañen la calidad del aire ni violen los NAAQS.

b. Cumplimiento de límites de incremento para evitar el deterioro de la calidad del aire. - Planes de implementación estatales (SIP):

a. AERMOD ayuda a los estados a desarrollar planes integrales para mantener y mejorar la calidad del aire.

b. Evaluar el impacto de las fuentes y diseñar estrategias de control de la contaminación. - Permisos de Operación Título V:

a. AERMOD empleado en el proceso de solicitud para demostrar el cumplimiento de los estándares de emisiones. - Cumplimiento de NAAQS:

a. AERMOD evalúa las emisiones de las fuentes para determinar el cumplimiento de los estándares NAAQS. - Evaluaciones de contaminantes atmosféricos peligrosos (CAP):

a. AERMOD evalúa la dispersión y concentración según NESHAP para garantizar que no haya riesgos significativos para la salud o el medio ambiente. - Evaluaciones de Impacto Ambiental:

a. AERMOD modela el impacto en la calidad del aire de las acciones propuestas en las Declaraciones de Impacto Ambiental. - Planes de Gestión de Riesgos (RMP):

a. AERMOD se puede utilizar para modelar impactos potenciales de liberaciones accidentales en RMP. - Monitorización de cercas y estudios de exposición comunitaria:

a. AERMOD predice la dispersión y concentración de contaminantes para evaluar el impacto ambiental cercano.

En estos contextos, AERMOD garantiza una evaluación exhaustiva de los impactos de las emisiones en la calidad del aire, facilitando el cumplimiento de los estándares ambientales y apoyando el compromiso de la EPA de proteger la salud pública y el medio ambiente de los efectos adversos de la contaminación del aire.

Para un cumplimiento perfecto y una gestión integral de la calidad del aire, considere el software AERMOD View de Lakes Environmental. Con capacidades de modelado avanzadas, agiliza el cumplimiento normativo en diversos contextos, salvaguardando sus operaciones y garantizando el cumplimiento de los estándares ambientales. Optimice su gestión de la calidad del aire con AERMOD View para obtener resultados sólidos, eficientes y confiables.

- Detalles

- Categoría: Minitab

- Visto: 2426

En un reciente webinar impartido por la Dra. Lourdes Pozueta (Directora de AVANCEX+i, consultora en mejora continua e innovación, y colaboradora de Addlink Software Científico), se exploraron las posibilidades que ofrece el análisis predictivo en combinación con las herramientas de aprendizaje automático (machine learning) de Minitab.

Todo empieza con la pregunta fundamental de los expertos en las organizaciones: ¿Por qué existe tanta variabilidad en el comportamiento de los individuos? ¿Hay patrones que podemos identificar para obtener insights valiosos? Estos interrogantes plantean la base para comprender cómo el análisis predictivo puede ayudar a anticipar comportamientos aleatorios en los siguientes contextos:

- Predecir: anticiparnos a los posibles escenarios futuros basados en datos históricos y patrones identificados.

- Encontrar pistas para buscar las causas: Es importante recordar que correlación no implica causalidad. Sin embargo, el análisis de datos puede ayudarnos a identificar posibles relaciones y pistas que nos guíen hacia las verdaderas causas de los fenómenos observados.

Minitab ofrece herramientas intuitivas que permiten a expertos y no expertos en algoritmia obtener resultados significativos con solo un clic y sin necesidad de usar un lenguaje de programación. No obstante, a pesar de los avances tecnológicos en computación, es importante comprender que el machine learning no es una solución mágica que sustituye la experiencia y el conocimiento humano: es una herramienta poderosa, pero siempre se necesita la guía del experto del tema en que se está trabajando y el pensamiento estadístico para recoger datos de calidad e interpretar los resultados de manera adecuada.

La analítica predictiva ofrece numerosas aplicaciones que se exploran en detalle en el webinar: desde la clasificación de datos hasta la predicción de valores de respuesta en conjuntos de datos supervisados. También se enfrenta al desafío de trabajar con datos no supervisados, donde la agrupación de datos con características similares es fundamental para obtener insights relevantes.

El análisis predictivo con machine learning resuelve importantes desafíos frente a la analítica clásica. Por ejemplo, cuando no existe una relación lineal clara entre las variables predictoras y la variable de respuesta, hay presencia de grupos con comportamientos diferentes, existe una alta dimensionalidad en los datos (más variables que individuos y/o variables muy correlacionadas) y existencia de datos aberrantes o incompletos.

Minitab ofrece una variedad de herramientas de machine learning, como árboles de decisión CART®, MARS®, TreeNet® y Random Forests®, que se adaptan a diferentes contextos y necesidades analíticas. Estas herramientas permiten a los usuarios explorar y analizar datos de manera eficiente, generando modelos predictivos robustos que respaldan la toma de decisiones informadas y ayuda a los expertos a encontrar valor en los datos. Sin embargo, el papel del experto sigue siendo crucial en todo el proceso, desde la recopilación de datos hasta la interpretación de los resultados.

Es fundamental formar a los expertos en habilidades analíticas y estadísticas para aprovechar al máximo estas herramientas: qué herramientas predictivas hay, que resultados aportan, sensibilidad frente a datos de no calidad… Con un entrenamiento (formación) adecuado se puede aportar mucho valor al experto para lograr obtener información de valor que abra nuevas oportunidades para la innovación y el crecimiento empresarial.

![Imagen de cabecera obtenida de [1], Flow Around an Inclined NACA 0012 Airfoil, Application ID: 14629 por COMSOL Imagen de cabecera obtenida de [1], Flow Around an Inclined NACA 0012 Airfoil, Application ID: 14629 por COMSOL](/images/productos/comsol/2024/cover.png)