- Detalles

- Categoría: Minitab

- Visto: 7149

Bridgestone Corporation, la empresa de neumáticos y productos de caucho más grande del mundo, fabrica neumáticos en diferentes instalaciones alrededor del mundo para su uso en una amplia variedad de aplicaciones. Sus productos se venden en más de 150 países y territorios. Entre las instalaciones de la empresa se encuentra su planta de Costa Rica, que produce 12,000 neumáticos cada día para 23 mercados en Centroamérica y el Caribe y emplea a más de 1,000 personas. Sin embargo, la planta enfrentaba dos desafíos: lograr la certificación de un nuevo neumático cumpliendo con las regulaciones del Departamento de Transporte de EE.UU. y superar un cuello de botella que limitaba la producción general de neumáticos para camiones ligeros en la planta. El black belt en Six Sigma Kenneth Quirós Acuña se embarcó en un proyecto que, de tener éxito, resolvería ambos desafíos. Él y el equipo del proyecto utilizaron Minitab Statistical Software para identificar los factores críticos que afectan tanto los niveles de producción como las pruebas de certificación, diseñar un experimento para encontrar la configuración óptima de esos factores y desarrollar un modelo que la empresa pudiera utilizar para producir y certificar más neumáticos con mayor rapidez.

El reto

El principal cuello de botella en la producción era la falta de bandas de rodamiento. La máquina de bandas de rodamiento de cintas estaba siendo subutilizada, pero aunque se intentó incrementar su uso, los neumáticos creados con ella no reunían los requisitos necesarios para la certificación. Programar la máquina había resultado extremadamente difícil. “No es fácil reproducir una forma de banda usando cintas porque hay que encontrar la combinación correcta de factores”, afirma Quirós.

Quirós y su equipo se dieron cuenta de que con tantos pasos en el proceso de fabricación de neumáticos, y tantos factores posibles, primero era necesario limitar el enfoque para crear un proyecto manejable. Alrededor del 80 por ciento de los problemas estaban relacionados con una prueba específica de certificación de neumáticos.

Los neumáticos que cumplen con las estrictas especificaciones pasan a la prueba del émbolo, en la que un émbolo redondeado se inserta de manera forzada en el centro de la banda de rodamiento de un neumático inflado. Un neumático que no pasa la prueba del émbolo no puede certificarse, así que fue allí donde centraron sus esfuerzos.

Conozca cómo con las herramientas de diseño de experimentos de Minitab Statistical Software, Bridgestone rediseñó la manera en que utilizaban las bandas de rodamiento de cintas para fabricar los neumáticos para camiones ligeros, aumentado la producción en la planta de Costa Rica, ahorrando cientos de miles de dólares y con un resultado de más de 2 millones de dólares en costos de oportunidad.

- Detalles

- Categoría: Comsol

- Visto: 3831

Todos los productos de software de COMSOL® han experimentado mejoras de estabilidad que se han introducido como una actualización. La siguiente lista contiene las mejoras más importantes de COMSOL® versión 5.2a update 3, que no estaban incluidas en las actualizaciones previas:

CFD Module

- Se ha corregido un problema que anteriormente impedía que los modelos que contenían la funcionalidad multifísica Multiphase Flow, Level-Set creada en la versión 5.2 se abriera en la versión 5.2a.

- En la interfaz Fluid-Structure Interaction (FSI), se han corregido referencias incorrectas a la variable G0 para en su lugar referir a G0_fluid. Esto elimina los problemas con errors de variables desconocidas cuando se resuelven algunos problemas FSI.

- En la ventana de ajustes para las funcionalidades de acoplamiento multifísico Two-Phase Flow, Level Set y Two-Phase Flow, Phase Field, las expresiones para el coeficiente de tensión superficial previamente inaccesibles ahora están disponibles.

- Cuando se selecciona el modelo Non-Newtonian Carreau para definer la viscosidad dinámica del segundo fluido en las funcionalidades de acoplamiento Two-Phase Flow, Level Setmultiphysics, se ha añadido una variable para el parámetro del modelo Carreau previamente desaparecida.

Heat Transfer Module

- Se ha añadido una variable previamente desaparecida en la subfuncionalidad Line Heat Source bajo el nodo Thin Rod. Los modelos con esta subfuncionalidad Line Heat Source ahora pueden ser resueltos sin errores.

- Un problema con una variable desconocida en la subfuncionalidad Pressure Work ha sido corregido. El problema ocurría cuando esta subfuncionalidad se utilizaba desde un nodo Fluid.

- La definición de gamma, el ratio de calores específicos, en la zona de transición de fase, se ha corregido para tener en cuenta los cambios de la capacidad calorífica y la densidad en cada fase.

LiveLink™ for MATLAB®

- Se ha solucionado un problema que causaba que la función envolvente mphglobal devolviese el conjugado complejo de los números complejos resultantes.

Particle Tracing Module

- Ahora es possible tener subfuncionaliades Nuclear Stopping multiples con la misma función Screening.

- Se ha mejorado el manejo de fuerzas dielectroforéticas, magnetoforéticas y acustoforéticas cuando se selecciona un studio Frequency Domain bajo "Values of variables not solved for" en la sección "Values of Dependent Variables" de los ajustes del estudio Time Dependent.

- Un error que ocurría cuando un conjunto de datos Particle o Ray precedía al conjunto de datos Solution en Model Builder ahora se ha corregido.

- Se ha mejorado la gestión de unidades geométricas no SI para la funcionalidad Release from Point.

Ray Optics Module

- Se ha mejorado la gestión al utilizar la funcionalidad Illuminated Surface en combinación con una malla móvil.

- Ahora existe una gestión más robusta de las condiciones de contorno en una malla móvil.

- Se ha solucionado un error que ocurría al utilizar "Specular reflection" como la condición de pared "Otherwise" para la funcionalidad Wall.

- Se ha mejorado la estabilidad par alas funcionalidades de lanzamiento de rayos cuando se desmarca la casilla de verificación "Allow propagation outside selected domains".

- Ahora se pueden seleccionar aristas de referencia para dispositivos ópticos como el Polarizador Lineal incluso si están rodeados por el domino vacío exterior fuera de la geometría.

- Se ha solucionado un error que ocurría cuando un conjunto de datos de Partícula o Rayo precedía al conjunto de datos Solución en el Model Builder.

- Ahora se soporta el trazado de rayos en dominios no mallados para modelos con mallas importadas.

Structural Mechanics Module

- Los valores diferentes al valor por defecto para el grosor del domino no se tenía en cuenta al calcular el efecto de la presión de poro en la funcionalidad External Stress en modelos 2D. Ahora se ha solucionado y los resultados son independientes del grosor para modelos de tensión plana 2D, tal y como se esperaba.

- Ahora es posible utilizar un nodo Fixed Constraint en la interfaz Truss cuando una interfaz Truss y una interfaz Solid Mechanics son utilizadas en el mismo componente.

- Para la interfaz Beam en 2D, las funcionalidades Prescribed Velocity y Prescribed Acceleration no vuelven a utilizar incorrectamente el valor introducido por el usuario.

- La subfuncionalidad Viscoelasticity configurada para utilizar el modelo Kelvin-Voigt ahora funciona correctamente cuando la funcionalidad de material padre es un material lineal ortotrópico o lineal anisotrópico.

COMSOL Server™

- Esta actualización incluye unas cuantas mejoras de estabilidad.

- Detalles

- Categoría: Comsol

- Visto: 5289

Cómo mejorar los modelos realizados con COMSOL Multiphysics

Optimization Module es un paquete complementario de COMSOL Multiphysics que puede utilizarse con cualquiera de los módulos de COMSOL Multiphysics. El objetivo de este módulo, como el de cualquier proceso de optimización, es el de optimizar un diseño mediante la maximización/minimización de una función objetivo, variando las variables de diseño sujetas a ciertas restricciones.

Por tanto, el primer paso es crear un modelo de COMSOL Multiphysics de un producto o proceso. Siempre va a ser deseable mejorar su diseño. Para ello definiremos una función objetivo (factor de mérito que describe el sistema). Definiremos también un conjunto de variables de diseño, que serán las entradas al modelo que se desean cambiar para mejorar el diseño. A continuación se definen un conjunto de restricciones, límites en las variables de diseño, o condiciones de funcionamiento que tienen que satisfacerse. Finalmente, se utiliza los resolvedores de Optimization Module para mejorar el diseño cambiando las variables de diseño, a la vez que se satisfacen las restricciones.

Optimization Module es una interfaz general para definir funciones objetivo, especificar variables de diseño, y ajustar esas restricciones. Cualquier entrada del modelo, ya sean dimensiones geométricas, formas de piezas, propiedades de los materiales o distribución de materiales, puede tratarse como una variable de diseño, y cualquier salida del modelo puede utilizarse para definir la función objetivo. Puede ser utilizada en toda la familia de productos de COMSOL Multiphysics y puede combinarse con los productos LiveLink™ para optimizar una dimensión geométrica en un programa CAD de tercera parte.

Dos tipos de aproximaciones: sin derivadas y basados en el gradiente

Optimization Module dispone de algoritmos para dos técnicas diferentes de optimización, una basada en el gradiente y otra libre de derivadas. La optimización libre de derivadas es útil cuando las funciones objetivo y restricciones son discontinuas o no tienen derivadas analíticas. Este sería el caso, por ejemplo, de cuando se desea minimizar la tensión de pico de una pieza cambiando sus dimensiones. Sin embargo, cuando las dimensiones cambian, la posición de las tensiones de pico pueden desplazarse de un punto a otro. Esta función objetivo no es analítica y por tanto requiere un planteamiento sin derivada. En el módulo Optimization Module se dispone de cuatro de estos métodos: son los métodos Bound Optimization by Quadratic Approximation (BOBYQA), Nelder-Mead, Búsqueda coordinada y Monte Carlo.

Optimization Module calculará un gradiente aproximado para hacer evolucionar las variables del diseño hacia un diseño mejorado. Se puede desear minimizar la masa total de la pieza lo que se puede hacer también utilizando este planteamiento. La masa de la pieza normalmente es diferenciable directamente respecto a las dimensiones de la pieza, permitiendo el uso de una aproximación basada en el gradiente. Optimization Module calculará la derivada analítica exacta de las funciones objetivo y restricciones utilizando el método adjunto del optimizador SNOPT, desarrollado por Philip E. Gill de la Universidad de California San Diego y Walter Murray y Michael A. Saunders de la Universidad de Stanford, para mejorar las variables de diseño. Un segundo algoritmo basado en el gradiente es el resolvedor Levenberg-Marquardt. Se puede utilizar este resolvedor cuando la función objetivo es del tipo mínimos cuadrados, típicamente utilizado para aplicaciones de estimación de parámetros y ajuste de curvas. Un tercer método, el método de asíntotas móviles (Method of Moving Asymptotes o MMA), es un resolvedor de optimización basado en el gradiente escrito por el Professor K. Svanberg del Royal Institute of Technology de Estocolmo, Suecia. Se diseñó con la optimización de la topología en mente. El método recibe el nombre de GCMMA en la literatura y está disponible en el módulo Optimization Module bajo el nombre MMA.

La ventaja del método basado en el gradiente es que puede tratar problemas que involucren cientos, e incluso miles, de variables de diseño con muy poco incremento del coste computacional a medida que el número de variables de diseño crece. El método Adjunto simultáneamente calcula todas las derivadas analíticas, mientras que el método sin derivadas tiene que aproximar cada derivada, y tomará más tiempo a medida que el número de variables de diseño crecen. Los métodos basados en el gradiente también pueden incluir funciones de restricción más complejas.

La ventaja del método sin derivadas es su simplicidad. No requiere encontrar una función objetivo diferenciable y requiere mucho menos interacción con el usuario para su configuración. Sin embargo, debido a los costes computacionales, los métodos sin derivadas son los más atractivos cuando el número de variables de diseño es aproximadamente menor o igual a 10. En la práctica, esto cubre un amplio rango de problemas prácticos de optimización de ingeniería.

La Optimización de Parámetros involucra optimizar cualquier entrada escalar al modelo, como los niveles de flujo y magnitudes de carga. Usualmente es el tipo de optimización más fácil y puede realizarse con cualquier técnica. La Estimación de Parámetros es más compleja, e involucra la correlación de un modelo de COMSOL con datos experimentales. Típicamente, el objetivo es utilizar un modelo para estimar las propiedades del material utilizado.

Optimization Module también permite realizar optimización de las dimensiones, formas y topología del modelo de COMSOL

Los métodos de optimización también pueden clasificarse por los tipos de variables que se optimizan. Tanto la optimización de dimensiones, como de formas y topología se realizan en el módulo Optimization Module, y cada una tiene su propio sitio en el proceso de diseño.

La optimización dimensional involucra la definición de variables de diseño que pueden llevarse directamente a fabricación. Algunas variables de diseño típicas pueden ser el tamaño de orificios, o longitud, groso y altura de miembros estructurales. La optimización dimensional se utiliza habitualmente como el último paso en el proceso de diseño y se realiza una vez que el diseño se ha fijado más o menos en términos de la forma global. Usualmente aquí se utiliza un método sin derivadas.

La optimización de forma normalmente ocurre en etapas previas del proceso de diseño, e involucra una alteración más libre de la forma del objeto. Usualmente se requiere más cuidado para escoger las variables de diseño, ya que el objetivo es mejorar la forma sin sobre restringir el diseño. Si se puede encontrar una función objetivo analítica se prefiere utilizar un método basado en gradiente.

La optimización de topología se utiliza en etapas muy tempranas del proceso de diseño, normalmente en la fase conceptual. La optimización de topología trata la distribución de material como una variable de diseño e inserta o elimina estructuras para mejorara la función objetivo. Debido al gran número de variables de diseño únicamente es práctica la optimización basada en gradiente.

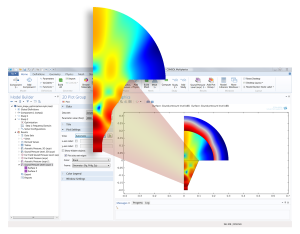

La imagen de la cabecera muestra la optimización de forma de una antena de bocina: Una bocina acústica con un lado inicialmente recto es optimizada para mejorar el nivel de presión sonora de campo lejano. Se utiliza optimización de forma para llegar a las corrugaciones onduladas de la bocina. Imagen cedida por COMSOL y realizada con COMSOL Multiphysics®

- Detalles

- Categoría: Humusoft

- Visto: 8401

Humusoft ha informado de la discontinuidad de su tarjeta de adquisición de datos AD622. Para los clientes interesados en tarjetas PCI, ésta puede ser sustituida por la tarjeta MF624, que es equivalente pero con un conjunto de funcionalidades más completo.

Las tarjetas disponibles por Humusoft son actualmente MF 624, MF 634 y MF 644.

- Detalles

- Categoría: Twinn Witness

- Visto: 5914

Traducido del artículo de David Jones publicado en Quality Magazine

La simulación predictiva está apuntalando las fábricas del futuro a través de la visualización inmersiva de la gran cantidad de datos obtenidos de los componentes y máquinas de la Industria 4.0.

Según un reciente artículo, la fábrica del futuro es “el producto de rápido cambio, con tecnologías disruptivas que golpean a la fabricación como un ciclón.” Dicho así, se le puede perdonar por pensar que esta factoría del futuro, basada en el concepto de la Industria 4.0, es algo que temer. Pero, en realidad, estas tecnologías disruptivas tienen el potencial de transformar radicalmente la fabricación, incrementando eficiencias, productividad y la rentabilidad global de las empresas en todo el mundo.

Guiada en parte por el Internet de las Cosas, la Industria 4.0 representa sin duda el cambio más revolucionario para impactar en el sector de la producción durante algún tiempo, con negocios impulsados a seguir los modelos digitales que abarcan la conectividad, el análisis de datos y el enfoque en los clientes. El objetivo general de esta cuarta revolución industrial es facilitar la ejecución de una "fábrica inteligente", donde las múltiples fuentes de datos en juego darán lugar a una mayor automatización, mayor perspectiva y toma de decisiones optimizadas.

UNA ABUNDANCIA DE DATOS

Los forofos de los grandes volúmenes de datos (Big Data), defienden que todos los datos son valiosos y por tanto deben de ser útiles. La realidad en la mayoría de las empresas es que no saben lo que hacer con sus datos o todavía están trabajando para saber qué preguntas deben hacerse sobre los mismos. Los fabricantes podrían disponer de las soluciones de análisis de datos exhaustivos más eficientes pero serían inútiles para tratar datos contextualizados en procesos y operaciones obsoletas e ineficientes. Para esas empresas que no deseen quedarse atrás cuando el “ciclón” golpee, ahora es el momento de empezar a dar sentido a sus necesidades de datos, poniendo el marco sólido sobre el cual construir la fábrica del futuro.

Aquí es donde la simulación predictiva entra en juego. Para optimizar resultados, la simulación debe ocupar el lugar que le corresponde como un proceso de negocio integral, vital, no solo para definir el alcance y diseñar la fábrica del futuro sino también para facilitar la comunicación de futuras operaciones antes de iniciar cualquier transformación. El uso efectivo de la simulación plantea cuestiones clave de gestión de procesos para asegurar que las partes interesadas comprendan la naturaleza dinámica e interconectada de su negocio, proporcionando nuevos conocimientos sobre cómo se ejecutan los procesos y cómo se aplican las políticas, destacando las áreas en las que aún faltan datos particularmente valiosos, y garantizando que las empresas son tan eficientes y productivas como sea posible.

GESTIÓN DE LA COMPLEJIDAD

Entonces, ¿cuáles son las características específicas de las fábricas del mañana para las que la simulación puede ayudar a prepararse? En primer lugar, se requiere una nueva fuerza de trabajo inteligente para gestionar la empresa del futuro. Esta fuerza de trabajo necesitará tanto comprender las operaciones en juego como actuar sobre los conocimientos encontrados en los datos que las fabricas inteligentes serán capaces de producir. Procesos operacionales interconectados, variabilidad (que nunca se puede eliminar del todo), retroalimentación o pasos repetitivos de procesos, compartición de recursos y políticas de prioridades —todo incrementa el nivel de gobernabilidad que este tipo de operaciones requiere.

La necesidad de una solución que sea capaz de manejar este nivel de complejidad es de suma importancia para equipar con éxito a una nueva fuerza de trabajo inteligente con conocimientos de su operación existente y la previsión para asegurar que se van a realizar cambios de políticas, decisiones de inversión y asignación de recursos para lograr el resultado deseado.

Mapeando y analizando un espectro de variables de producción en un modelo operacional particular, la predicción facilita una comprensión de las complejas relaciones entre procesos en múltiples y variadas etapas. Los modelos pueden probarse utilizando diferentes escenarios para descubrir cambios estratégicos y tácticos para una producción optimizada. En particular, los procesos que involucren alta conectividad, variabilidad, interrupciones y complejidad de interacciones son ideales para la simulación. Otras técnicas para medir estos procesos, como hojas de cálculo Excel y Mapeos de la Cadena de Valor, a menudo ignoran o tratan atributos como medias estáticas, lo que puede tener implicaciones críticas en la toma de decisiones. Y, a medida que las empresas se hacen digitalmente más complejas y conectadas con la Industria 4.0, estas implicaciones pueden llegar a cambiarlas radicalmente.

EXPANSIÓN DE LA CADENA DE SUMINISTROS

Este nuevo nivel de complejidad no acaba con los procesos. Una parte integral de la fábrica del futuro es la extensión y expansión de las cadenas de suministro, que rompe las barreras comerciales tradicionales y trasciende las cuatro paredes de una simple instalación para trabajar incluso más cerca de los clientes, los proveedores, los organismos de la industria y el mundo académico. Esta idea de la empresa extendida es fundamental para el concepto global de Industria 4.0, donde esta manera colaborativa de trabajar se ve como la única manera de optimizar la productividad.

La simulación tiene la capacidad de modelar un ecosistema completo de fabricación y componentes de cadena de suministro, como plazos de ejecución, costes, distancias, proveedores, etc. facilitando una comprensión incluso más profunda de las complejas relaciones entre, no tan solo procesos internos del negocio, sino también entre socios del negocio, o clientes y proveedores. Llevando claridad y control a los socios colaborativos, la simulación puede maximizar un potencial de negocio, suavizando los enlaces y estableciendo los canales de comunicación más eficientes para facilitar la transición a la forma de trabajar de la fabrica inteligente.

LA VELOCIDAD ES LA ESENCIA

Las escalas de tiempo más cortas y crecientes eficiencias que son subproductos de procesos optimizados se anticipan en términos de la necesidad de mejora de la agilidad global del negocio. Para alcanzar la excelencia operacional real, alcanzando los niveles de agilidad requeridos para responder rápidamente e incluso predecir, nuevas oportunidades de negocio y cambios de mercado, los negocios necesitan tomar decisiones a alta velocidad, más eficientemente. Incluso las operaciones más eficientes se ralentizarán debido a retrasos en la toma de decisiones, particularmente si las decisiones no son las correctas cuando finalmente se materialicen.

La única manera de asegurar toma de decisiones más rápidas y más eficientes es teniendo acceso a la información correcta, en el momento correcto, en el contexto correcto. De nuevo, la simulación es clave. La información producida llevando a cabo simulación predictiva a través del negocio es robusta, en tiempo real y contextualizada. Los responsables de tomar decisiones entonces pueden utilizar esta información y apoyar sus decisiones, con la seguridad de que las decisiones están basadas en la mejor información disponible. La adopción de una cultura de modelado para la toma de decisiones a nivel directive asegura que la simulación es el primer Puerto de llamada cuando se tienen que realizar decisiones complejas, algo que mantendrá al negocio en una buena posición ya que la velocidad de toma de decisiones crecerá en línea con el ritmo creciente del negocio de la fábrica del futuro.

FACILIDAD DE USO

Otro área donde la simulación guiará a la fábrica del futuro es en la usabilidad de la tecnología. Con la única reserva de expertos en modelado y simulación, la simulación va saliendo de las sombras y de los escritorios de los usuarios de negocios. La naturaleza interdependiente de la fábrica del futuroe significará que más personal, no técnico, no especializado, estará involucrado, haciendo que lo más importante sea que estas herramientas proporcionen los mayores niveles de rendimiento necesario pero en un paquete útil, accesible y visual.

La realidad virtual (VR) es un gran ejemplo de esto. Un modelo simulado de su negocio proporciona potentes datos del estado futuro en un medio fácilmente consumible, desmitificando mucho de los procesos analíticos al proporcionar una experiencia visual interactiva, ayudando tanto a analistas como a los responsables de toma de decisiones a comprender sus procesos, datos y cómo se afectan entre sí. Llevando los problemas del mundo real en el mundo de realidad virtual, visualizando dinámicamente los diversos resultados potenciales y seleccionando el mejor curso de acciones, la simulación permite a los negocios el lujo de poder realizar test exhaustivos sin los riesgos y costes asociados de los test en un entorno vivo, optimizando procesos en preparación para la industria del futuro.

RECETA DEL ÉXITO

Para muchos, los datos son la clave que permite la fábrica del futuro. Sin embargo, antes de intentar responder a esos datos, es vital que los negocios conozcan qué datos recoger, cómo contextualizarlos y cómo utilizarlos. Y mientras no existe una única solución para transformar repentinamente un negocio en una empresa digital de alto rendimiento, los negocios pueden hacer cosas mucho peores que adoptar las capacidades de la simulación predictiva como medio para prepararse para la transición a la fábrica del futuro.

Ahora es el momento para reconsiderar procesos y procedimientos. Antes de pasar al ámbito de las analíticas Big Data, los negocios deberían de trabajar estrechamente con su proveedor de simulación para asegurarse de que están haciendo un uso completo del software. Únicamente así estarán en primera posición para adoptar la fábrica del futuro en toda su bondad.

- Detalles

- Categoría: Maple

- Visto: 6666

Los motores ultrasónicos, utilizados en cámaras y otras aplicaciones, presentan dificultades de modelado únicas. Los fenómenos creados en los que las ondas ultrasónicas con altas frecuencias son producidos son difíciles de capturar en un modelo. El modelo debe de ser preciso y ejecutarse rápidamente para llegar a ser útil en el diseño del controlador. Las técnicas actuales de modelado tienen inconvenientes. Sin embargo, el uso de un Modelo de Orden Reducido creado por la Reducción del Orden del Modelo de un Modelo de Elementos Finitos ha demostrado grandes ventajas. Con la ayuda de las capacidades de cálculo avanzadas de Maple:

- Las dificultades del modelado complejo se redujeron

- Se creó un modelo preciso de un motor ultrasónico

- El modelo se creó en una fracción del tiempo requerido previamente con otras técnicas de modelado