- Detalles

- Categoría: Comsol

- Visto: 2658

¡El próximo día 25 de septiembre de 2021 es la fecha límite para la matriculación en el Máster MUCOM!.

El Máster Universitario Online en Simulación Numérica en Ciencia e Ingeniería con COMSOL Multiphysics (MUCOM) ofrece una formación fundamental y completa sobre simulación numérica y optimización aplicadas. La duración del máster es de un curso académico, de principios de octubre a principios de junio.

El máster es completamente online y en español, y está organizado por la Universidad de Málaga (España), con la colaboración de Addlink Software Científico y COMSOL y con la participación de profesorado de estas empresas y de las Universidades de Málaga, Politécnica de Barcelona, Complutense de Madrid y Almería. La matriculación en el máster incluye el uso del software COMSOL Multiphysics, con licencia docente, y la posibilidad de realizar el Trabajo Fin de Máster en nuestras Empresas Tecnológicas o Centros de Investigación colaboradores.

En esta documento de presentación encontrará toda la información.

Si está interesado, puede encontrar toda la información sobre el máster MUCOM en la web del máster. También, puede enviar cualquier pregunta específica a la direcciónde la dirección académica (Emilio Ruiz Reina, multifisica_info@uma.es)

- Detalles

- Categoría: Minitab

- Visto: 4203

El pasado 1 de junio de 2021 publicamos la noticia de la finalización del soporte técnico de la edición de Minitab 19 para Mac, de acuerdo a la política de soporte técnico de Minitab, Inc.

Atendiendo a esta política de soporte técnico de Minitab, puesto que Minitab 20 fue lanzado el 21 de octubre de 2020, el próximo 21 de octubre de 2021 se discontinuará el soporte técnico para la edición Windows de Minitab 19.

¿Qué ocurre cuando el soporte técnico es discontinuado?

Cuando finaliza el servicio de soporte técnico para una versión, los usuarios de esa versión no reciben ningún tipo de asistencia técnica. En particular, no se les facilita la reinstalación, activación o transferencia de las licencias de Minitab.

A partir del 21 de octubre de 2021, no será posible instalar Minitab 19 en un nuevo equipo y si deja de funcionar la instalación actual, no será posible volver a activarlo.

¡Actualice a Minitab 20.4!

Se recomienda a los actuales usuarios de licencias de Minitab 19 actualizar a la versión más reciente, Minitab 20.4, para evitar el impacto que puede suponer la imposibilidad de utilizar este software. Ponemos a su disposición unos atractivos y competitivos planes de actualización. ¡Póngase en contacto con nuestro departamento comercial!

- Detalles

- Categoría: Minitab

- Visto: 5744

Minitab Statistical Software se actualiza a la versión 20.4. Esta versión de mantanimiento contiene nuevas funcionalidades listadas más abajo además de solucionar algunos errores, por lo que se recomienda aplicar la versión a todos los usuarios de Minitab 20.

Nuevas funcionalidades

- Visualización Gráfica de Burbujas interactiva (Interactive Bubble Plot) disponible en el creador de gráficas (Graph Builder)

Esta actualización también es compatible con el nuevo módulo de Minitab Healthcare Module, el complemento opcional construido a propósito pensando en los profesionales de los servicios sanitarios. Ya no es necesario disponer de una formación en estadística al disponer de instrucciones directas, guías y páginas de soporte, todo con terminolgía del sector, de forma que los profesionales de los servicios sanitarios ahora pueden fácilmente calcular, analizar y mejorar los indicadores KPI (Key Process Indicators).

Por temas de seguridad, se han actualizado los requisitos del sistema y ahora ya no está soportado 8.1 para Minitab 20.4.

- Detalles

- Categoría: Minitab

- Visto: 5767

Por Stacey McDaniel.

Greg Kinsey es asesor de industria y consultor ejecutivo, y dirige las prácticas de fabricación de Hitachi Vantara en EMEA. Él y su equipo trabajan principalmente con empresas industriales europeas para ayudarles a visualizar, planificar y ejecutar transformaciones digitales. En sus propias palabras, ayuda a las empresas a ser “más esbeltas, más ecológicas, más ágiles y más productivas, utilizando herramientas digitales como medio”.

Greg tiene más de 30 años de experiencia trabajando con la industria manufacturera, principalmente en los sectores de automoción, electrónica, aeroespacial y de bienes de consumo, en todo el mundo. Tuvimos la oportunidad de conocer sus opiniones sobre varios temas de la ciencia de datos para este artículo.

¿QUÉ IMPORTANCIA TIENE DEMOCRATIZAR LA ANALÍTICA?

Creo que es de vital importancia que el análisis de datos sea parte integrante de casi todos los trabajos industriales. Ya se esté trabajando en una fábrica, una oficina, un centro de servicio o un puesto de cara al cliente, sin importar el puesto o la industria, en el mundo actual es fundamental tener el análisis de datos correcto al alcance de la mano. Los datos ayudan a tomar las mejores decisiones para que se pueda optimizar el trabajo que se está haciendo. Los datos evitan que se cometan errores. Tener los datos correctos para hacer el trabajo mejora la productividad, reduce el estrés y aumenta la satisfacción laboral.

¿QUÉ IMPORTANCIA TIENE LA ALFABETIZACIÓN EN DATOS PARA TODOS?

La alfabetización en datos es importante, pero quizás lo más importante es que necesitamos herramientas que nos permitan usar fácilmente los datos en el trabajo, de manera similar a como usamos los datos en casa. La revolución digital ocurrió primero como una revolución de consumo. Se trataba de comercio electrónico, redes sociales y datos personales. Casi todo el mundo tiene dispositivos digitales en casa, y casi siempre en la mano o en la muñeca. No importa cuáles sean sus pasatiempos, estoy seguro de que utiliza datos para ellos. Ya sea un corredor de maratones, chef aficionado o músico, restaurador de antigüedades o en la práctica de cualquier tipo de deporte, los datos están involucrados. Todo lo que hacemos en nuestra vida personal ahora utiliza datos, y esos datos nos ayudan a sacar más provecho de la vida. Todavía no hemos visto ese cambio completo en la vida laboral industrial.

Verdaderamente, las personas en la industria ya están recopilando y notificando algunos datos, pero no necesariamente obtienen los análisis correctos que necesitan para realizar mejor su trabajo. Este problema no trata tanto de la alfabetización de datos, sino que trata de organizaciones que crean el entorno adecuado y tienen las herramientas adecuadas en los lugares adecuados. Que son fáciles de usar. Eso conduciría a una democratización de la analítica en toda la fuerza laboral.

¿DEBERÍA SER MÁS ACCESIBLE LA CIENCIA DE DATOS PARA AMPLIAR LA COMUNIDAD DE USUARIOS? ¿POR QUÉ ES TAN VITAL?

La ciencia de datos debe convertirse en parte de todo lo que hacemos. El término "científico de datos" es engañoso; creo que cualquiera que utilice estadísticas básicas podría considerarse un científico de datos. Los datos de uso rigurosos ahora están aumentando en casi todos los roles profesionales. Entonces, eventualmente, todos nos convertiremos en "científicos de datos", como parte de cualquier trabajo que hagamos.

Estuve profundamente involucrado en el inicio del movimiento Six Sigma en la década de 1990. Fue entonces cuando reconocimos el poder de dar a los trabajadores industriales acceso a herramientas estadísticas básicas. No los llamamos "científicos de datos", sino que se nos ocurrió el término "cinturones negros" (Black Belt). Utilizaron la ciencia de datos para describir procesos, solucionar problemas y aplicar análisis básicos a las operaciones diarias. Ese fue el origen de cómo la ciencia de datos se arraigó en las operaciones industriales. Six Sigma creó la base para la transformación digital.

Hoy en día, el mundo empresarial realmente está empezando a aceptar el valor de los datos. Se ha demostrado que tiene un gran impacto en la productividad, la toma de decisiones e incluso en la reducción de los niveles de estrés de los empleados, ya que los problemas se pueden resolver de forma más rápida y sencilla con los datos correctos.

¿ES LO DIGITAL UN TEMA QUE VIVE SOLO DENTRO DEL DEPARTAMENTO DE TI?

Para nada. Creo que lo digital es un tema de toda la organización. El uso de datos y análisis, y las herramientas asociadas, debe extenderse a casi todas las funciones. Demasiadas empresas mantienen los datos aislados en manos de unos pocos "expertos", en lugar de permitir que todos accedan a datos que podrían ser útiles para ellos en su trabajo diario.

Nos estamos moviendo ahora hacia un mundo donde los gerentes operativos también son dueños de las estrategias digitales para sus funciones. Por lo tanto, cuando se habla con alguien que dirige un departamento de mantenimiento o un departamento de calidad o un departamento de marketing o una cadena de suministro, ellos son, o deberían ser, responsables de la digitalización de esas funciones.

Gran parte del trabajo de consultoría que hacemos como Hitachi es trabajar con los líderes funcionales.

El departamento de TI apoya la digitalización, pero veo que la transformación digital realmente se impulsa desde el punto de vista de las operaciones porque ahí es donde se sientan los usuarios. Los gerentes de operaciones saben mejor por dónde empezar con la digitalización y, a menudo, tienen una visión para sus operaciones futuras. Muchas de las mejores ideas provienen de personas que trabajan en las operaciones diarias, por lo que es importante involucrarlas en sus esfuerzos de diseño digital.

Este es un gran cambio con respecto a hace 20 años, cuando se implementaron nuevos sistemas y las organizaciones tuvieron que cambiar la forma en que trabajaban para adaptarse a la TI. Puedo recordar que muchas empresas adaptaron sus procesos comerciales para satisfacer sus requisitos de aplicaciones rígidas de MES o MRP. A menudo, esto impidió la innovación y la optimización operativas.

Ahora se está revirtiendo; tenemos la oportunidad de crear interfaces digitales, algoritmos y plataformas que tengan sentido para los procesos de trabajo. El método ágil se centra en los problemas a resolver y las experiencias de usuario requeridas. Luego, el departamento de TI debe respaldar esas innovaciones y hacer que se adapten a la infraestructura de TI general.

¿DEBEN LAS ORGANIZACIONES PRIORIZAR LA INVERSIÓN EN SOLUCIONES DE CÓDIGO BAJO Y SIN CÓDIGO?

Sí, absolutamente. Piense en cómo utilizamos nuestros teléfonos inteligentes. No necesitamos saber cómo codificar para hacer cosas útiles con ellos. Este debería ser el mismo caso con las herramientas de análisis en funcionamiento. La experiencia del usuario debe ser rápida, sencilla y relevante.

Durante los primeros días de la TI en el mundo empresarial, se trataba de herramientas sofisticadas que solo los expertos podían usar. ¿Recuerda a las personas a las que se les llamaba "programadores"? Hoy en día, se trata de encontrar herramientas de análisis que todos puedan utilizar. En Hitachi, estamos creando soluciones que no requieren una programación o codificación extensiva en lenguajes avanzados.

¿POR QUÉ LOS PROFESIONALES BASADOS EN DATOS NECESITAN ANÁLISIS PREDICTIVOS?

El análisis predictivo es un verdadero cambio de juego. La mayoría de los datos que se utilizan hoy en día en la industria son retrospectivos. Los datos históricos describen lo que sucedió en el pasado. En algunas áreas, los datos en tiempo real están disponibles, lo que permite ver lo que está sucediendo en este momento. Con la analítica avanzada actual, se puede comenzar a proyectar lo que sucederá, basándose en el comportamiento de los factores causales. Por ejemplo, tal vez el clima afecte a las operaciones. O tal vez un gran cambio en los tipos de cambio afectará a la estructura de costes. O hay un cambio rápido en las preferencias de los consumidores. Conviene recopilar y analizar datos sobre estos factores para comprender lo que está sucediendo hoy y mañana. Para comenzar a extrapolarlo para proyectar cómo se verá la próxima semana, o el próximo mes. Ahí es donde el análisis predictivo—Basado en aprendizaje automático y datos factoriales— permitirá ver el futuro.

Me gusta pensar en esto como un "viaje en el tiempo". El análisis predictivo brinda la capacidad de viajar a una fecha futura y crear escenarios, preguntando, "¿y si?". ¿Qué pasa si el mercado realmente va en una determinada dirección y la demanda realmente cambia de una manera específica? ¿Qué pasa si aceleramos o ralentizamos un proceso? ¿Qué tal simular cambios en el diseño de productos? ¿Qué pasa si se puede considerar el impacto de un resultado económico o político? ¿Cómo afectará eso a la economía o al entorno regulatorio en el que operamos? El alcance puede ser grande.

Luego puede agrupar todos estos factores y analizar los escenarios para el próximo año, el próximo trimestre o el próximo mes. Se empieza a ver cómo se desarrollarán estas diferentes relaciones de causa y efecto en el futuro. ¿Qué podemos hacer al respecto? ¿Qué cambios o acciones correctivas serán necesarias en tal escenario futuro? Aquí es donde viene el valor. Optimización del rendimiento futuro.

Por eso es tan importante. Puede ponerse al frente, puede anticipar lo que va a suceder para poder administrar mejor su negocio, su organización y sus procesos para hacer frente a todos los cambios que se avecinan. Se trata de ser ágil.

¿CREE QUE LOS INGENIEROS PUEDEN TRANSFORMARSE EN CIENTÍFICOS DE DATOS CON TECNOLOGÍA DE CÓDIGO BAJO, O SIN CÓDIGO?

¡Absolutamente! Me formé como ingeniero; mi licenciatura es en ingeniería mecánica. Aprendí que la ingeniería se trata de resolución de problemas, modelado matemático y aplicación del método científico. La ciencia de datos es parte de eso.

El advenimiento de la tecnología que reduce la necesidad de una programación compleja para acceder y utilizar los datos está impulsando un mayor uso de la ciencia de datos dentro de la comunidad de ingenieros. Pero es mucho más amplio que eso. Más allá de la comunidad de ingenieros es donde viene la gran ganancia, cuando los trabajadores calificados que operan máquinas, conducen vehículos, mantienen equipos, realizan funciones de fabricación, cuando todas esas personas comienzan a convertirse en científicos de datos, esas pueden ser las mayores ganancias. Y no nos olvidemos de los gerentes, incluido el C-suite o grupo directivo: también se están convirtiendo en "científicos de datos".

Cuando toda la organización tiene mejores datos y herramientas de análisis fáciles de usar, eso permite "ciencia de datos para todos". Creo que este es uno de los elementos fundamentales de la cuarta revolución industrial.

- Detalles

- Categoría: Twinn Witness

- Visto: 3736

Lanner ha anunciado que la última versión del software insignia de simulación predictiva, WITNESS Horizon 24.0, ya está disponible.

Diseñado pensando en la facilidad de uso y la velocidad para responder, WITNESS Horizon 24.0 combina a la perfección el modelado de escritorio eficiente y la ejecución escalable en la nube, lo que permite a los usuarios trabajar de manera más productiva y tomar decisiones comerciales inteligentes mediante simulación, experimentación, optimización y visualización.

Experimentación a escala con WITNESS: la visión

Durante más de 20 años, el software de simulación predictiva WITNESS de Lanner ha permitido a las empresas construir gemelos digitales de sus operaciones. Durante este tiempo, Lanner se ha comprometido a evolucionar con las demandas de los clientes y la tecnología, convirtiendo WITNESS en la herramienta productiva, escalable e integrada de desarrollo e implementación que es hoy.

Con esta visión a la vanguardia de nuestros ciclos de desarrollo, WITNESS Horizon 24.0 ha sido diseñado para admitir la implementación escalable de múltiples escenarios de experimentación, con características mejoradas y una nueva conectividad totalmente integrada al servicio de ejecución en la nube basado en la suscripción de Lanner, WITNESS.io.

WITNESS.io, un servicio basado en web que permite implementar modelos WITNESS en la nube, ofrece acceso a múltiples núcleos virtuales, lo que significa que los escenarios se pueden ejecutar de manera eficiente en una huella de tecnología cero, sin comprometer el tiempo del modelador o la capacidad del escritorio.

WITNESS.io también brinda características y beneficios adicionales a los clientes, lo que permite que las soluciones WITNESS se integren en sistemas externos, como lo demuestra el trabajo que hemos realizado con The MTC y su proyecto Factory in a Box o aplicaciones personalizadas, como Lanner's Brewery Game, que utiliza la tecnología WITNESS.io para ejecutar los escenarios creados por los jugadores.

Análisis turboalimentado

WITNESS ya cuenta con capacidades de experimentación, que permiten a los usuarios experimentar y optimizar modelos de manera rápida y efectiva, aprovechando el poder del procesamiento de múltiples núcleos en la PC del modelador. Sin embargo, los clientes buscan cada vez más ampliar la cantidad de experimentos que están ejecutando, lo que, según el tamaño y la complejidad de los modelos, puede llevar una cantidad significativa de tiempo cuando se confía en la capacidad de procesamiento propia del escritorio para manejar tantos escenarios.

Ahora, con WITNESS Horizon 24.0, los usuarios pueden suscribirse a WITNESS.io para proporcionar tanta capacidad escalable como necesiten, directamente dentro de WITNESS, y luego ejecutar múltiples experimentos a gran escala. Esta conectividad integrada entre WITNESS Horizon 24.0 y WITNESS.io permite a los usuarios ejecutar modelos más rápido que nunca, en múltiples núcleos en la nube.

Grandes lotes de experimentos que alguna vez llevaron horas, ahora pueden realizarse en minutos, lo que genera una experimentación y una generación de resultados más eficientes.

Potenciando el modelado predictivo de gemelos digitales

Las nuevas funciones de WITNESS Horizon 24.0 están diseñadas para capacitar a los modeladores y analistas a medida que ejecutan modelos de simulación como parte de la estrategia Digital Twin de su organización.

A medida que aumentan las demandas de tiempo y se necesitan respuestas comerciales más rápidas que nunca, WITNESS Horizon 24.0 maximizará la productividad de la experimentación y facilitará una forma más eficiente de trabajar con activos de simulación predictiva, liberando más tiempo para analizar los resultados del escenario y tomar decisiones más informadas.

Si es un cliente en mantenimiento, puede descargar WITNESS Horizon 24.0 desde el portal MyLanner hoy mismo.

- Detalles

- Categoría: Comsol

- Visto: 3517

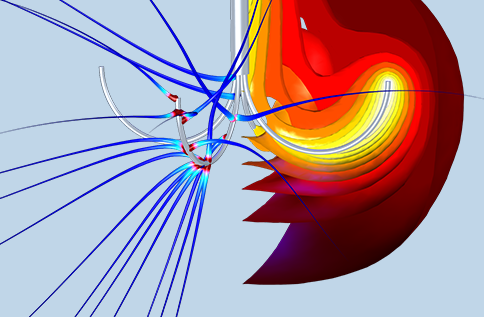

En este enlace puede ver las grabaciones de las ponencias principales sobre simulación de aplicaciones biomédicas, que tuvieron lugar durante el COMSOL Day: Biomedical devices. En él se presentó el uso de simulaciones multifísicas en el desarrollo de dispositivos médicos innovadores y nuevos métodos de tratamientos. Ahora las grabaciones ya están disponibles en el apartado de videos de la web de COMSOL.

- Detalles

- Categoría: Comsol

- Visto: 6078

En este artículo vamos a presentar un par de entradas del blog de COMSOL en las que se trata el ajuste de curvas de datos en COMSOL Multiphysics, con dos utilidades diferentes muy prácticas:

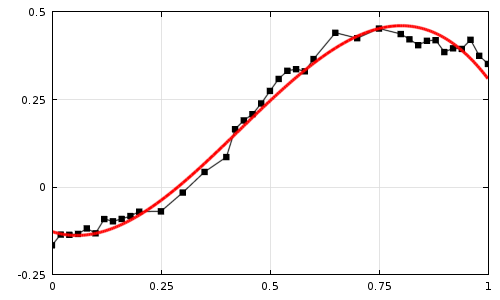

En la entrada más antigua, "Ajuste de curvas de datos experimentales con COMSOL Multiphysics", Walter Frei presenta cómo ajustar datos experimentales discretos, con gran utilidad para el trabajo de simulación subsiguiente. Muchas veces las fluctuaciones estadísticas que presentan los datos experimentales importados pueden dificultar la convergencia del resolvedor al realizar la simulación. Por eso suele ser conveniente procesarlos y ajustar esos datos discretos a una función uniforme, lo que proporciona acceso a derivadas de orden superior de esa función, mientras que la diferenciación numérica de los datos sin procesar podría ser muy ruidosa y propensa a errores.

En una reciente entrada del blog, "Ajuste de curvas de datos de soluciones en COMSOL Multiphysics®", Christopher Boucher nos explica como después de resolver un modelo en COMSOL Multiphysics®, es posible que deseemos ajustar los datos de la solución a un conjunto de funciones definidas en el dominio de simulación. Aquí se considera el ajuste de datos de solución continuos, para luego presentar el concepto de ortogonalidad y explicar cómo ajustar los datos de la solución a un conjunto de funciones ortogonales se reduce a una operación de posprocesado simple y conveniente.